| Vorheriges Thema anzeigen :: Nächstes Thema anzeigen |

| Autor |

Nachricht |

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3628

|

(#1877985) Verfasst am: 31.10.2013, 00:45 Titel: WEIRDOS - warum die meisten Studien falsch sind. (#1877985) Verfasst am: 31.10.2013, 00:45 Titel: WEIRDOS - warum die meisten Studien falsch sind. |

|

|

Ich möchte zwei Studien vorstellen, die nach meiner Lesart ziemlich "einschlagen". Weitermachen wie bisher geht nun nicht mehr.

Teil 1:

Zwei Kern-Absätze habe ich übersetzt, damit auch mitlesen kann, wer mit dem Englischen nicht ganz vertraut ist.

Kurzfassung: die meisten Studien über menschliches Verhalten sind WEIRD. Soll heißen, sie basieren auf Probanden, die aus Gesellschaften stammen, die unter western, educated, industrialised, rich, democratic fallen. Deshalb können sie nicht verallgemeinert werden.

Der Aufsatz beginnt recht deftig:

| Zitat: | Die in den tropische Wäldern von Neu-Guinea beheimateten Etoro glauben, daß ein Junge, der erwachsen werden will, den Samen Älterer aufnehmen muß. Das geschieht durch ein Initiationsritual, in dem der Junge bei einen Erwachsenen Fellatio ausübt. (Herdt 1984, Kelley 1980). Im Gegensatz dazu wird es beim Nachbarstamm der Kaluli als notwendig erachtet, daß der Samen über den Anus des Initiierten aufgenommen wird, nicht über den Mund. Die Etoro verachten diese Praxis und finden sie abstoßend. [...]

Solche Detailstudien von "exotischen" Gesellschaften, die üblicherweise unter Anthropologie fallen, sind wesentlich für unser Verständnis der Variationsbreite menschlichen Verhaltens. Aber dieser Aufsatz soll nicht von diesen Völkern handeln. Er handelt von einer anderen exotischen Gruppe: von Menschen aus westlichen, schulisch gebildeten, industrialisierten, reichen und demokratischen Gesellschaften.

Insbesondere geht es um westliche und genauer gesagt US-amerikanische Studenten, auf denen der Großteil aller Daten beruht, die die experimentellen Zweige von Psychologie, Kognitionswissenschaften und Ökonomie, wie auch die verwandten Gebiete (zusammengefasst als "Verhaltenswissenschaften" gesammelt haben. Nachdem unser Wissen über die menschliche Psyche hauptsächlich auf Resultaten basiert, die auf diesem Bevölkerungsschnitt basiert, fragen wir uns, wie repräsentativ diese Ergebnisse sind. Ist es berechtigt, diese Ergebnisse zu verallgemeinern? |

| Zitat: | Die schmale Faktenbasis in den Verhaltenswissenschaften

Welche Probanden werden von den Verhaltenswissenschaften untersucht? Eine kürzliche Analyse der angesehensten Periodika aus sechs Unterdisziplinen der Psychologie aus den Jahren 2003 - 2007 ergab, daß 68% der Versuchspersonen aus den USA stammten, 96% aus westlichen, industrialisierten Ländern, namentlich Nordamerika, Europa, Australien und Israel. (Arnett 2008). Die Zusammensetzung entsprach im Wesentlichen der Herkunft der Autoren, 73% stammten aus US-amerikanischen Universitäten, 99% aus westlichen Ländern. Das bedeutet, daß 96% aller Stichproben aus Ländern stammen, die nur 12% der Weltbevölkerung stellen. [...]

Sogar innerhalb der westlichen Welt ist die Stichprobe nicht repräsentativ. Im "Journal of Personality and Social Psychology", der angesehensten Zeitschrift für social psychology [wie übersetzt man das?] basiern 67% der US-Stichproben (und 80% der Stichproben aus anderen Ländern) ausschließlich aus Befragungen von Vordiplomanden [undergraduates] der Psychologie. Dabei sollten gerade diese Disziplinen besonderes Augenmerk auf die Auswahl ihrer Versuchspersonen legen. |

Für's Archiv hier die Original-Version:

| Zitat: | In the tropical forests of New Guinea the Etoro believe that for a boy to achieve manhood he must ingest the semen of his elders. This is accomplished through ritualized rites of passage that require young male initiates to fellate a senior member (Herdt 1984, Kelley 1980). In contrast, the nearby Kaluli maintain that male initiation is only properly done by ritually delivering the semen through the initiate’s anus, not his mouth. The Etoro revile these Kaluli practices, finding them disgusting. To become a man in these societies, and eventually take a wife, every boy undergoes these initiations.

Such in-depth studies of “exotic” societies, historically the province of anthropology, are crucial for understanding human behavioral variation. However, this paper is not about these peoples. It’s about another exotic group: people from Western, Educated, Industrialized, Rich, and Democratic (WEIRD1) societies. In particular, it’s about the Western, and more specifically American, undergraduates who form the bulk of the database in the experimental branches of psychology, cognitive science, and economics, as well as allied fields (labeled the “behavioral sciences”). Given that scientific knowledge about human psychology is largely based on findings from this population, we ask just how representative are these typical subjects in light of the available comparative database. How justified are researchers in assuming a species‐level generality of their findings? |

| Zitat: | The Behavioral Sciences Database is Narrow

Who are the people studied in behavioral science research? A recent analysis of the top journals in six sub‐disciplines of Psychology from 2003‐2007 revealed that 68% of subjects came from the US, and a full 96% of subjects were from Western industrialized countries, specifically North America, Europe, Australia, and Israel (Arnett 2008). The make‐up of these samples appears to largely reflect the country of residence of the authors, as 73% of first authors were at American universities, and 99% were at universities in Western countries. This means that 96% of psychological samples come from countries with only 12% of the world’s population. Put another way, a randomly selected American is 300 times more likely to be a research participant in a study in one of these journals than is a randomly selected person from outside of the West.

Even within the West, however, the typical sampling method for psychological studies is far from representative. In the Journal of Personality and Social Psychology, the premier journal in social psychology—the sub‐discipline of psychology that should (arguably) be the most attentive to questions about the subjects’ backgrounds—67% of the American samples (and 80% of the samples from other countries) were composed solely of undergraduates in psychology courses (Arnett 2008). |

*geht gleich weiter*

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3628

|

(#1877990) Verfasst am: 31.10.2013, 00:54 Titel: (#1877990) Verfasst am: 31.10.2013, 00:54 Titel: |

|

|

Fast jedes im Aufsatz genannte Beispiel wäre einen eigenen Beitrag wert. Ich fasse mich kurz und reiße einige Themen daraus nur plakativ an.

Mueller-Lyer-Illusion

Wer sich auch nur im Entferntesten mit Optischen Illusionen beschäftigt hat, kennt diese Illusion. Eigentlich gehört das zur Allgemeinbildung, oder?

http://de.wikipedia.org/wiki/Müller-Lyer-Illusion

Allerdings tritt diese Illusion nicht bei allen Völkern der Erde auf.

Die Autoren vermuten, die Ursache der Illusion liege darin, daß wir in Häusern mit rechten Winkeln aufwachsen.

Ultimatum-Game

Ein Ergebnis der Spieltheorie ist, daß Kooperation bei wiederholten Spielen die bessere Strategie ist. Das geht sogar soweit, daß Spieler, die nicht kooperieren wollen, von anderen Spielern bestraft werden. Wie weit das geht, scheint aber gesellschaftsabhängig zu sein.

Linguistik

- WEIRDoes denken in abstrakten Kategorien: Fisch, Säugetier, Baum

- andere denken in konkreten Beispielen: Forelle, Fuchs, Ahorn.

| Zitat: | | [...] basic level biological categories for WEIRD adults are life-form categories (e.g., bird, fish, and mammal) and these are also the first categories learned by children: e.g., If you say “what’s that” (pointing at a maple tree), the common answer is “tree”. However, in all small-scale societies studied, the generic species (e.g., trout, fox, and maple) are the basic level category and the first learned by children (Atran 1993, Berlin 1992). |

Analytische vs. Ganzheitliche Urteile

Moral Reasoning

| Zitat: | A central concern in the developmental literature has been the way people acquire the cognitive foundations of moral reasoning. The most influential approach to the development of moral reasoning has been Kohlberg’s (1971, 1976, 1981) framework, in which people’s abilities to reason morally are seen to hinge on cognitive abilities that develop over maturation. Kohlberg proposed that people progressed through the same three levels: 1) children start out at a pre-conventional level, viewing right and wrong as based on the physical or hedonistic consequences of actions; 2) then they progress to a conventional level, where moral behavior is perceived to be that which maintains the social order of their group; and finally 3) some progress further to a post-conventional level, evaluating right and wrong on the basis of abstract ethical principles regarding justice and individual rights—the moral code inherent in the U.S. Constitution.

While all of Kohlberg’s levels are commonly found in WEIRD populations, much subsequent research has revealed scant evidence for post-conventional moral reasoning in other populations. One metaanalysis carried out with data from 27 countries found consistent evidence for post-conventional moral reasoning in all the Western urbanized samples, yet found no evidence for this type of reasoning in small-scale societies (Snarey 1985). Furthermore, it is not just that formal education is necessary to achieve Kohlberg’s post-conventional level. Some highly educated non-Western populations do not show this post-conventional reasoning. At Kuwait University, for example, faculty members score lower on Kohlberg’s schemes than the typical norms for Western adults, and the elder faculty there scored no higher than the younger ones, contrary to Western patterns (Al-Shehab 2002, Miller et al. 1990). |

Ich denke, das reicht für TLDNR.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

River Queen

audiophil.

Anmeldungsdatum: 16.07.2009

Beiträge: 3516

Wohnort: Ochrasy

|

(#1877992) Verfasst am: 31.10.2013, 01:13 Titel: (#1877992) Verfasst am: 31.10.2013, 01:13 Titel: |

|

|

DANKEEEE!

_________________

No coins. It's change I need.

|

|

| Nach oben |

|

|

Alphatierchen

Mostly harmless

Anmeldungsdatum: 24.09.2007

Beiträge: 4218

|

(#1877998) Verfasst am: 31.10.2013, 02:33 Titel: (#1877998) Verfasst am: 31.10.2013, 02:33 Titel: |

|

|

Sehr interessant. Wenn auch nicht wirklich verwunderlich. Wenn man sich ansieht, wie nach Probanden gesucht wird, dann fällt schnell auf, dass man außerhalb universitärer Bereiche kaum auf Studien aufmerksam gemacht wird. Die meisten Probanden werden nach meiner Erfahrung über Mailinglisten von Universitäten oder Aushängen in Unis gewonnen. Außerdem sind es gerade Studenten die meist die Zeit haben um an Studien teilzunehmen und zudem das Geld gebrauchen können.

Weitere Probleme gibt es wenn Forschungseinrichtungen sehr dezentral liegen. Wer will denn schon weit fahren, um an einer Studie teilzunehmen für die er am Ende 10-20€ bekommt? Das führt dann dazu, dass teilweise Mitarbeiter und vor allem Praktikanten als Probanden herhalten müssen, da man sonst nicht an genug Studienteilnehmer kommt.

Ist zwar eher off topic aber eine kleine Anmerkung zur Müller-Lyer Illusion.

Die Theorie von Richard Gregory ("Misapplied Size Constancy Scaling"), auf die sich die Autoren beziehen, ist recht umstritten. Leider hält sie sich dennoch hartnäckig in Büchern, wenngleich andere Theorien kaum Erwähnung finden.

Z.B. kann die Theorie nicht erklären, warum die sog. Dot-Version der Müller Lyer Illusion einen Illusioneffekt zeigt, da diese keine Tiefeninformation beinhaltet. Nach Gregory's Theorie dürfte diese Version eigentlich keinen Illusioneffekt zeigen. Allerdings sei auch angemerkt, dass die Dot-Version einen schwächeren Illusionseffekt auslöst als die klassiche Müller-Lyer Illusion. Daher ist es also gut möglich, dass Gregory's "Misapplied Size Constancy Scaling" eben nur ein Teil der Wahrheit darstellt.

Leider sind mir keine Studien zu kulturellen Unterschieden dieser oder anderer Versionen der Müller-Lyer Illusion bekannt.

|

|

| Nach oben |

|

|

esme

lebt ohne schützende Gänsefüßchen.

Anmeldungsdatum: 12.06.2005

Beiträge: 5667

|

(#1878044) Verfasst am: 31.10.2013, 11:07 Titel: (#1878044) Verfasst am: 31.10.2013, 11:07 Titel: |

|

|

Das ist jetzt keine taufrische Meldung. Insofern ist "weitermachen wie bisher geht nun nicht mehr" schlicht falsch, da im Widerspruch zu den Fakten.

_________________

Gunkl über Intelligent Design:

Da hat sich die Kirche beim Rückzugsgefecht noch einmal grandios verstolpert und jetzt wollen sie auch noch Haltungsnoten für die argumentative Brez'n, die sie da gerissen haben.

|

|

| Nach oben |

|

|

Naastika

RL rulez<->auf Wunsch deaktiviert

Anmeldungsdatum: 23.11.2003

Beiträge: 6100

Wohnort: an der Fütterungsstelle der Eichhörnchen

|

(#1878071) Verfasst am: 31.10.2013, 13:19 Titel: (#1878071) Verfasst am: 31.10.2013, 13:19 Titel: |

|

|

| Thx smallie, sehr interessant. Da ich nicht "vom Fach" bin, ist die Aktualitätsfrage für mich irrelevant.

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3628

|

(#1878260) Verfasst am: 31.10.2013, 23:05 Titel: (#1878260) Verfasst am: 31.10.2013, 23:05 Titel: |

|

|

| Alphatierchen hat folgendes geschrieben: | Sehr interessant. Wenn auch nicht wirklich verwunderlich. Wenn man sich ansieht, wie nach Probanden gesucht wird, dann fällt schnell auf, dass man außerhalb universitärer Bereiche kaum auf Studien aufmerksam gemacht wird. Die meisten Probanden werden nach meiner Erfahrung über Mailinglisten von Universitäten oder Aushängen in Unis gewonnen. Außerdem sind es gerade Studenten die meist die Zeit haben um an Studien teilzunehmen und zudem das Geld gebrauchen können.

Weitere Probleme gibt es wenn Forschungseinrichtungen sehr dezentral liegen. Wer will denn schon weit fahren, um an einer Studie teilzunehmen für die er am Ende 10-20€ bekommt? Das führt dann dazu, dass teilweise Mitarbeiter und vor allem Praktikanten als Probanden herhalten müssen, da man sonst nicht an genug Studienteilnehmer kommt. |

Ja, richtig.

Hinzu kommt, daß der finanzielle Rahmen oft recht enge Grenzen setzen wird.

Speziell bei medizinischer Forschung gibt es auch eine ethische Frage: ist es gerechtfertigt, eine Studie zu wiederholen, wenn eine vorhergehende gezeigt hat, daß Medikament X bei Krankheit Y hilft? Ist es gerechtfertigt, den Patienten dann noch ein Plazebo zu geben?

| Alphatierchen hat folgendes geschrieben: | Ist zwar eher off topic aber eine kleine Anmerkung zur Müller-Lyer Illusion.

Die Theorie von Richard Gregory ("Misapplied Size Constancy Scaling"), auf die sich die Autoren beziehen, ist recht umstritten. Leider hält sie sich dennoch hartnäckig in Büchern, wenngleich andere Theorien kaum Erwähnung finden. <schnipp>

|

Interessant. Das kannte ich noch nicht.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3628

|

(#1878261) Verfasst am: 31.10.2013, 23:06 Titel: (#1878261) Verfasst am: 31.10.2013, 23:06 Titel: |

|

|

| esme hat folgendes geschrieben: | | Das ist jetzt keine taufrische Meldung. |

Taufrisch ist das in der Tat nicht mehr. Aber die SUFU sagt, das hatten wir noch nicht.

Es würde mich interessieren, ob dies heutzutage zum Grundlehrstoff in den betroffenen Fachrichtungen gehört.

| esme hat folgendes geschrieben: | | Insofern ist "weitermachen wie bisher geht nun nicht mehr" schlicht falsch, da im Widerspruch zu den Fakten. |

Mag sein, daß mir bei der Formulierung ein bisschen der Gaul durchgegangen ist.

Allerdings gibt es schon einige Ansätze, dem Problem entgegenzutreten. Zum Beispiel ein Journal, das sich hauptsächlich der Reproduktion von Studien widmet. Oder auch das Bestreben, daß Studien "angemeldet" werden sollen, so daß Negativresultate nicht mehr unter den Tisch fallen. Überhaupt hat "Negativresultat" eine schlechte Konnotation, die es eigentlich nicht verdient. Wer kann schon eine akademische Karriere auf einem Negativresultat aufbauen?

PS:

Michaelson/Morleys Versuch zur Konstanz der Lichtgeschwindigeit war übrigens so ein Negativresultat. Da hätte eigentlich etwas anderes dabei herauskommen sollen.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3628

|

(#1878262) Verfasst am: 31.10.2013, 23:07 Titel: (#1878262) Verfasst am: 31.10.2013, 23:07 Titel: |

|

|

Teil 2

Dies kommt aus der Medizin. Die Schlußfolgerungen lassen sich aber leicht auf andere Gebiete übertragen, denke ich.

| Zitat: | Why Most Published Research Findings Are False

John P. A. Ioannidis - 2005

Bereits veröffentlichte Forschungsergebnisse werden manchmal durch spätere Erkenntnisse widerlegt, was zu Verwirrung und Enttäuschung führt. Widerlegungen und Kontroversen finden sich in der ganzen Bandbreite von Versuchsanordnungen, von klinischen Studien, klassischen epidemiologischen Studien bis zur den modernsten molekularbiologischen Forschung. Es gibt zunehmend Bedenken, daß die Mehrzahl oder gar allergrößte Teil der veröffentlichten Forschungsergebnisse falsch sind. Überraschend ist das jedoch nicht. Es kann bewiesen werden, daß die meisten Ergebnisse falsch sind. Hier möchte ich die Schlüsselfaktoren, die dem Problem zugrunde liegen, untersuchen und einige Schlußfolgerungen daraus.

- Je kleiner eine Studie auf eine bestimmten Gebiet ist, desto eher ist sie falsch.

- Je kleiner der untersuchte Effekt ist, desto eher ist die Studie falsch.

- Je mehr mögliche Effekte untersucht werden und je geringer die Vor-Auswahl an getesteten Hypothesen ist, desto eher ist die Studie falsch.

- Je flexibler der Entwurf einer Studie, die dabei verwendeten Definitionen, Ergebnisse und Analysemethoden sind, desto eher ist eine Studie falsch.

- Je größer finanzielle oder andere Interessen und Vorurteile sind, die hinter einer Studie stehen, desto eher ist die Studie falsch.

- Je heißer ein Forschungsgebiet ist und je mehr Teams darin arbeiten, desto eher sind die Ergebnisse falsch.

http://www.ncbi.nlm.nih.gov/pmc/articles/PMC1182327/ |

Das sind zum Teil echte no brainer, aber es schadet sicher nicht, wenn das mal ausdrücklich gesagt wird. Denn oft genug wird jede neue Studie sofort für bare Münze genommen.

PS: fachliche Einwände zu den statistischen Überlegungen im Artikel würde ich gerne hören, falls jemand welche findet.

Wiederum für's Archiv die Stellen im Original.

| Zitat: | Published research findings are sometimes refuted by subsequent evidence, with ensuing confusion and disappointment. Refutation and controversy is seen across the range of research designs, from clinical trials and traditional epidemiological studies to the most modern molecular research. There is increasing concern that in modern research, false findings may be the majority or even the vast majority of published research claims. However, this should not be surprising. It can be proven that most claimed research findings are false. Here I will examine the key factors that influence this problem and some corollaries thereof.

- The smaller the studies conducted in a scientific field, the less likely the research findings are to be true

- The smaller the effect sizes in a scientific field, the less likely the research findings are to be true.

- The greater the number and the lesser the selection of tested relationships in a scientific field, the less likely the research findings are to be true.

- The greater the flexibility in designs, definitions, outcomes, and analytical modes in a scientific field, the less likely the research findings are to be true.

- The greater the financial and other interests and prejudices in a scientific field, the less likely the research findings are to be true.

- The hotter a scientific field (with more scientific teams involved), the less likely the research findings are to be true. |

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

Zuletzt bearbeitet von smallie am 31.10.2013, 23:14, insgesamt einmal bearbeitet |

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1878265) Verfasst am: 31.10.2013, 23:11 Titel: (#1878265) Verfasst am: 31.10.2013, 23:11 Titel: |

|

|

Danke Smallie für die Mühe, ein wirklich sehr interessantes Thema. Ich hoffe, ich werde vielleicht irgendwann in den nächsten Tagen (Wochen -.-) Zeit genug finden, etwas dazu zu sagen.

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

Skeptiker

"I can't breathe!"

Anmeldungsdatum: 14.01.2005

Beiträge: 16834

Wohnort: 129 Goosebumpsville

|

(#1878266) Verfasst am: 31.10.2013, 23:14 Titel: (#1878266) Verfasst am: 31.10.2013, 23:14 Titel: |

|

|

| smallie hat folgendes geschrieben: | Teil 2

Dies kommt aus der Medizin. Die Schlußfolgerungen lassen sich aber leicht auf andere Gebiete übertragen, denke ich.

| Zitat: | Why Most Published Research Findings Are False

John P. A. Ioannidis - 2005

Bereits veröffentlichte Forschungsergebnisse werden manchmal durch spätere Erkenntnisse widerlegt, was zu Verwirrung und Enttäuschung führt. Widerlegungen und Kontroversen finden sich in der ganzen Bandbreite von Versuchsanordnungen, von klinischen Studien, klassischen epidemiologischen Studien bis zur den modernsten molekularbiologischen Forschung. Es gibt zunehmend Bedenken, daß die Mehrzahl oder gar allergrößte Teil der veröffentlichten Forschungsergebnisse falsch sind. Überraschend ist das jedoch nicht. Es kann bewiesen werden, daß die meisten Ergebnisse falsch sind. Hier möchte ich die Schlüsselfaktoren, die dem Problem zugrunde liegen, untersuchen und einige Schlußfolgerungen daraus.

- Je kleiner eine Studie auf eine bestimmten Gebiet ist, desto eher ist sie falsch.

- Je kleiner der untersuchte Effekt ist, desto eher ist die Studie falsch.

- Je mehr mögliche Effekte untersucht werden und je geringer die Vor-Auswahl an getesteten Hypothesen ist, desto eher ist die Studie falsch.

- Je flexibler der Entwurf einer Studie, die dabei verwendeten Definitionen, Ergebnisse und Analysemethoden sind, desto eher ist eine Studie falsch.

- Je größer finanzielle oder andere Interessen und Vorurteile sind, die hinter einer Studie stehen, desto eher ist die Studie falsch.

- Je heißer ein Forschungsgebiet ist und je mehr Teams darin arbeiten, desto eher sind die Ergebnisse falsch.

http://www.ncbi.nlm.nih.gov/pmc/articles/PMC1182327/ |

Das sind zum Teil echte no brainer, aber es schadet sicher nicht, wenn das mal ausdrücklich gesagt wird. Denn oft genug wird jede neue Studie sofort für bare Münze genommen.

PS: fachliche Einwände zu den statistischen Überlegungen im Aufsätze würde ich gerne hören, falls jemand welche findet.

Wiederum für's Archiv die Stellen im Original.

| Zitat: | Published research findings are sometimes refuted by subsequent evidence, with ensuing confusion and disappointment. Refutation and controversy is seen across the range of research designs, from clinical trials and traditional epidemiological studies to the most modern molecular research. There is increasing concern that in modern research, false findings may be the majority or even the vast majority of published research claims. However, this should not be surprising. It can be proven that most claimed research findings are false. Here I will examine the key factors that influence this problem and some corollaries thereof.

- The smaller the studies conducted in a scientific field, the less likely the research findings are to be true

- The smaller the effect sizes in a scientific field, the less likely the research findings are to be true.

- The greater the number and the lesser the selection of tested relationships in a scientific field, the less likely the research findings are to be true.

- The greater the flexibility in designs, definitions, outcomes, and analytical modes in a scientific field, the less likely the research findings are to be true.

- The greater the financial and other interests and prejudices in a scientific field, the less likely the research findings are to be true.

- The hotter a scientific field (with more scientific teams involved), the less likely the research findings are to be true. |

|

Genau. Das passt ja auch zu dem anderen thread mit den Psychopharmakastudien.

_________________

Free Julian Assange! Lock up the Killers!

Populismus ist keine Verschwörungstheorie

Informationsstelle Militarisierung e.V.

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1878272) Verfasst am: 31.10.2013, 23:25 Titel: (#1878272) Verfasst am: 31.10.2013, 23:25 Titel: |

|

|

Dann mach mal eine ordentliche Meta-Analyse, die auf den Vorschlägen von Ioannidis basiert (oder verweis wengistens auf eine). Und versuch mal, zwischen einem Forschungsfeld mit einer Vielzahl an Studien und relativ großen Effektgrößen und solchen, bei denen es nur wenige Studien mit geringer statistischer Power und relativ kleinen Effektgrößen, zu unterscheiden.

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

AgentProvocateur

registrierter User

Anmeldungsdatum: 09.01.2005

Beiträge: 7851

Wohnort: Berlin

|

(#1878298) Verfasst am: 01.11.2013, 01:15 Titel: Re: WEIRDOS - warum die meisten Studien falsch sind. (#1878298) Verfasst am: 01.11.2013, 01:15 Titel: Re: WEIRDOS - warum die meisten Studien falsch sind. |

|

|

| smallie hat folgendes geschrieben: | | Kurzfassung: die meisten Studien über menschliches Verhalten sind WEIRD. Soll heißen, sie basieren auf Probanden, die aus Gesellschaften stammen, die unter western, educated, industrialised, rich, democratic fallen. Deshalb können sie nicht verallgemeinert werden. |

Auch von mir erst mal vielen Dank für Deine Mühe. Eine sehr interessante Studie.

Ein erster Einwand dazu: daraus folgt mE aber nicht, dass diese Studien deswegen (weil sie nur WEIRDs untersuchen) falsch seien - falls Du "falsch" im Sinne von irrelevant meinst; es folgt zwar vielleicht, dass man diese Studien nicht auf Nicht-WEIRDs verallgemeinern kann, aber nicht, dass sie wertlos seien. Studien, die lediglich WEIRDs als Probanden haben, kann man zwar nicht einfach so z.B. auf Amazonasvölker übertragen, jedoch durchaus auf andere WEIRDs.

Nehmen wir z.B. mal dieses Forum hier, das Freigeisterhaus. Schätzungsweise 90% der User hier sind WEIRDs im obigen Sinne, würde ich mal annehmen.

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3628

|

(#1878472) Verfasst am: 01.11.2013, 23:19 Titel: Re: WEIRDOS - warum die meisten Studien falsch sind. (#1878472) Verfasst am: 01.11.2013, 23:19 Titel: Re: WEIRDOS - warum die meisten Studien falsch sind. |

|

|

| AgentProvocateur hat folgendes geschrieben: | | Ein erster Einwand dazu: daraus folgt mE aber nicht, dass diese Studien deswegen (weil sie nur WEIRDs untersuchen) falsch seien - falls Du "falsch" im Sinne von irrelevant meinst; es folgt zwar vielleicht, dass man diese Studien nicht auf Nicht-WEIRDs verallgemeinern kann, aber nicht, dass sie wertlos seien. Studien, die lediglich WEIRDs als Probanden haben, kann man zwar nicht einfach so z.B. auf Amazonasvölker übertragen, jedoch durchaus auf andere WEIRDs. |

Das stimmt natürlich, soweit es WEIRDo-Versuche betrifft, wie in Teil 1 beschrieben.

Allerdings schlägt danach immer noch die "Ioannidis-Klatsche" aus Teil 2 zu. Die WEIRDo-Ergebnisse können und werden zum Teil falsch sein.

| Kival hat folgendes geschrieben: | (Er gehört zum "Lager" der Bayesianer  ) ) |

Es gibt noch Leute, die nicht zu den Bayesianern gehören? Es gibt noch Leute, die nicht zu den Bayesianern gehören?

Praktisches Beispiel: wenn ich einen AIDS-Test machen lasse und er fällt positiv aus, dann muß ich mir keine Sorgen machen. Höchstwahrscheinlich ist es ein falsch-positives Resultat. Außer ich gehöre zu einer Risikogruppe. Dann habe ich Grund zu Sorge.

Analoges gilt für Mammographie- und Prostatakrebs-Tests. Wenn ich darüber nachdenke, dann hatte esme doch recht mit ihrem Einwand, "weitermachen wie bisher geht nun nicht mehr" schlicht falsch, da im Widerspruch zu den Fakten. Es wird einfach weitergemacht, trotz (mangels?) besseren Wissens.

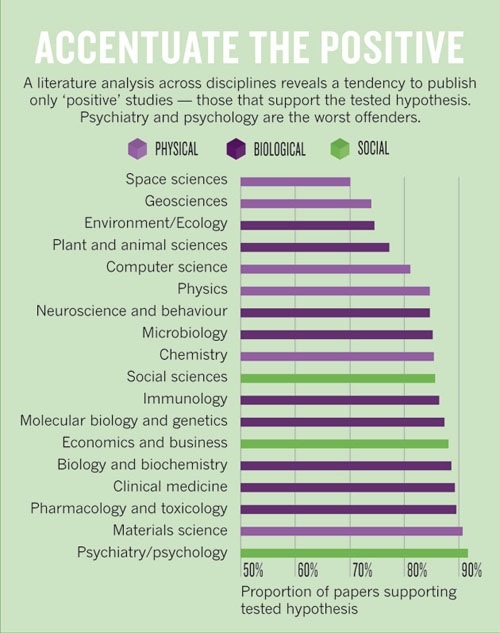

Das läßt sich leicht auf wissenschaftlich Studien übertragen. Diese Graphik zeigt das recht anschaulich. Wenn die "statistische Power" kleiner als die erwähnten 0,8 ist, sieht es noch schlechter aus.

http://www.economist.com/news/briefing/21588057-scientists-think-science-self-correcting-alarming-degree-it-not-trouble

Das Verhältnis von 100 wahren Tatsachen auf 1000 Hypothesen bei wissenschaftlichen Studien ist umstritten. Manche sagen, es sei zu niedrig - Wissenschaftler würde doch nicht jedem Unfug nachgehen. Andere sagen, es sei zu hoch - wenn zum Beispiel eine Datensammlung computergestützt auf alle möglichen Korrelationen geprüft wird.

Eine Lösung des Problems wäre es, zukünftig Negativresultat nicht mehr so leichtfertig zu verwerfen, sondern sie einfach zu publizieren. Dazu hab' ich noch was, aber nicht mehr heute.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

esme

lebt ohne schützende Gänsefüßchen.

Anmeldungsdatum: 12.06.2005

Beiträge: 5667

|

(#1878484) Verfasst am: 02.11.2013, 00:58 Titel: (#1878484) Verfasst am: 02.11.2013, 00:58 Titel: |

|

|

| smallie hat folgendes geschrieben: | | esme hat folgendes geschrieben: | | Das ist jetzt keine taufrische Meldung. |

Taufrisch ist das in der Tat nicht mehr. Aber die SUFU sagt, das hatten wir noch nicht.

Es würde mich interessieren, ob dies heutzutage zum Grundlehrstoff in den betroffenen Fachrichtungen gehört.

| esme hat folgendes geschrieben: | | Insofern ist "weitermachen wie bisher geht nun nicht mehr" schlicht falsch, da im Widerspruch zu den Fakten. |

Mag sein, daß mir bei der Formulierung ein bisschen der Gaul durchgegangen ist.

|

Der Grund, warum mich die Formulierung besonders geärgert hat, ist die Sache, dass du diesen Thread "geschlossen" formuliert hast. Du bringst hier eine durchaus interessante, aber relativ alte Meldung in etwas übertriebenem Stil und machst dann keinen Thread über Probleme in Studien oder über kulturellen Bias in der Wissenschaft oder so, sondern du bringst nur diese Meldung und öffnest im ersten Beitrag überhaupt nicht zu einer Diskussion, in die man auch andere Probleme einbringen könnte (medizinische studien nur an Männern, Reproduktion eines falschen physikalischen Wertes vermutlich ohne Betrug, usw.).

_________________

Gunkl über Intelligent Design:

Da hat sich die Kirche beim Rückzugsgefecht noch einmal grandios verstolpert und jetzt wollen sie auch noch Haltungsnoten für die argumentative Brez'n, die sie da gerissen haben.

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1878509) Verfasst am: 02.11.2013, 12:37 Titel: Re: WEIRDOS - warum die meisten Studien falsch sind. (#1878509) Verfasst am: 02.11.2013, 12:37 Titel: Re: WEIRDOS - warum die meisten Studien falsch sind. |

|

|

| smallie hat folgendes geschrieben: | | Kival hat folgendes geschrieben: | (Er gehört zum "Lager" der Bayesianer  ) ) |

Es gibt noch Leute, die nicht zu den Bayesianern gehören? Es gibt noch Leute, die nicht zu den Bayesianern gehören? |

Also zumindest in den Sozial- und Wirtschaftswissenschaften ist der Standard immer noch "frequentist statistics". An den Problemen der Veröffentlichungsbias etc. stören sich auch nicht nur Bayesianer. Hier sind eher die Lager der naiven Anwender und der Statistiker gespalten.

Disclaimer: Faktisch bin ich bisher sicher auch "frequentist", ich kenne mich mit Bayesian statistics auch noch nicht wirklich gut aus, finde aber Gelman z.B: sehr empfehlenswert.

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1878515) Verfasst am: 02.11.2013, 13:42 Titel: (#1878515) Verfasst am: 02.11.2013, 13:42 Titel: |

|

|

Relativ weit oben auf meiner Liste steht ansonsten folgender Artikel, vielleicht ist der ja für dich auch interessant. Ist zwar nur sehr kurz, aber ich hatte noch keine Zeit...

Gelman, Andrew, und Christian P. Robert. 2013. „“Not only defended but also applied”: The perceived absurdity of Bayesian inference“. The American Statistician 67 (1): 1–5.

Frei zugänglich unter: http://arxiv.org/pdf/1006.5366

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

NoReply

registrierter User

Anmeldungsdatum: 21.09.2013

Beiträge: 683

|

(#1878792) Verfasst am: 03.11.2013, 18:02 Titel: Wie relevant ist das? (#1878792) Verfasst am: 03.11.2013, 18:02 Titel: Wie relevant ist das? |

|

|

Hallo,

stellt sich aber auch die Frage wie relevant das überhaupt ist.

Bei klinischen Studien wird ja bereits die Wirksamkeit von Medikamenten nach Ethnie unterschieden:

http://www.gen-ethisches-netzwerk.de/gid/163/thema/duster/wiedergeburt-des-rassebegriffs

| Zitat: | | 2003, Januar: Die US-amerikanische Zulassungsbehörde für Arzneimittel und medizintechnische Produkte FDA (Food and Drug Administration) empfiehlt bei klinischen Versuchen fünf einheitliche Kategorien für „Rasse“ und „Ethnizität“ zugrunde zu legen. Laut FDA sei es dadurch möglich „Unterschiede in der physischen Reaktion von ethnischen Gruppen frühzeitig zu erkennen.“ |

Andere Studien haben von Anfang an nicht den Anspruch für die gesamte Menschheit zu gelten, sondern nur für ein bestimmtes Land. (z.B. Die Studie der Friedrich-Ebert-Stiftung zu Rechtsextremismus in Deutschland)

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3628

|

(#1878796) Verfasst am: 03.11.2013, 18:26 Titel: Re: WEIRDOS - warum die meisten Studien falsch sind. (#1878796) Verfasst am: 03.11.2013, 18:26 Titel: Re: WEIRDOS - warum die meisten Studien falsch sind. |

|

|

| smallie hat folgendes geschrieben: | | Eine Lösung des Problems wäre es, zukünftig Negativresultat nicht mehr so leichtfertig zu verwerfen, sondern sie einfach zu publizieren. Dazu hab' ich noch was, aber nicht mehr heute. |

| Zitat: | Replication studies: Bad copy

Ed Yong - Nature - 2012

Das deutlichste Zeichen, daß auf ihrem Gebiet etwas im Argen lag, war für viele Psychologen ironischer Weise eine Studie über Hellseherei [premonition]. Daryl Bem, ein Sozialpsychologe an der Cornell Universität in Ithaka, New York, zeigte studentischen Freiwilligen 48 Wörter und ließ sie danach niederschreiben, welche sie davon behalten hatten. Es folgte eine Übungssitzung: die Studenten bekamen einen Teil der Testbegriffe und mußten sie abtippen. Bem fand heraus, daß manche Studenten jene Wörte, die sie hinterher übten, im ersten Test besser erinnert hatten. Der Effekt ging der Ursache voraus.

Bem veröffentlichte sein Resultat im Journal of Personality and Social Psychology (JPSP) zusammen mit acht weiteren Experimenten, die er als Beleg nimmt für, wie er es nennt, "PSI" oder "mediale Einflüsse" [psychic effects]. Es gab - man muß es nicht ausdrücklich sagen - keinen Mangel an Wissenschaftlern, die seinen Ergebnissen skeptisch gegenüberstanden. Drei Versuchsteams versuchten unabhängig von einander die gleichen Effekte zu reproduzieren, von denen Bem berichtet hatte. Als sie es nicht konnten trafen sie auf erheblichen Wiederstand, ihre Ergebnisse zu veröffentlichen. Dies war wie ein Weck-Ruf. "Die Erkenntnis, daß ein gewisser Teil der Ergebnisse in der Fachliteratur einfach nicht replizierbar sein könnte, wird einem durch mehr und immer mehr kontraintuitive Ergebnisse in der Literatur vor Augen geführt", sagt Eric-Jan Wagenmakers, ein mathematischer Psychologe an der Universität Amsterdam.

Positive Resultate aus der Psychologie sind wie Gerüchte: leicht zu verbreiten, aber schwer auszuräumen. Sie überwiegen in den meisten Zeitschriften, welche bestrebt sind neue und aufregende Forschung vorzustellen. Gleichzeitig bleiben Versuche, diese Studien zu replizieren unveröffentlicht, insbesondere wenn sie negativ ausfallen; dann verkümmern sie in Schubladen oder werden nur in Kantinen-Gesprächen aufgegriffen. "Es gibt Experimente, von denen jeder weiß, das sie nicht wiederholbar sind, aber diese Wissen schafft es nicht bis in die Fachliteratur", sagt Wagenmakers. Die Veröffentlichungsschwelle kann ernüchternd sein, so Wagenmakers. "Ich kenne Studenten, die ihre ganze Doktorandenzeit über versucht haben, ein Phänomen zu replizieren, dabei gescheitert sind und die akademische Laufbahn verlassen haben, weil sie nichts vorzuweisen hatten, als es an der Zeit war."

http://www.nature.com/news/replication-studies-bad-copy-1.10634 |

Der Artikel erwähnt noch einige andere nennenswerte Dinge. Zum Beispiel eine nicht ernst gemeinte Studie, in der J. P. Simmons et. al zeigen, daß es die Lebenserwartung um 1,5 Jahre senkt, wenn man den Beatles-Song When I'm Sixty-four hört. Simmons sagt, es war erschreckend einfach [unacceptably easy], zu diesem Ergebnis zu kommen.

Oder auch:

| Zitat: | | Bei einer Befragung von 2 000 Psychologen fand Leslie John, Verbraucherpsychologe an der Harvard Business School, Boston, heraus, daß über 50% der Befragten ihre Entscheidung, noch mehr Daten zu sammeln davon abhängig machten, ob die bisherigen Daten signifikante Schlüsse zuließen. Sie warteten einfach, bis sich positive Ergebnisse einstellten. Über 40% hatten gezielt nur die Studien eingereicht, die "funktionierten". Die meisten Teilnehmer fanden dieses Vorgehen vertretbar. |

Das erinnert mich an das alte Bonmot, wie man mit einem Pfeil immer ins Schwarze trifft: man schießt zuerst und malt hinterher das Schwarze passend auf die Zielscheibe.

Originalzitate:

| Zitat: | For many psychologists, the clearest sign that their field was in trouble came, ironically, from a study about premonition. Daryl Bem, a social psychologist at Cornell University in Ithaca, New York, showed student volunteers 48 words and then abruptly asked them to write down as many as they could remember. Next came a practice session: students were given a random subset of the test words and were asked to type them out. Bem found that some students were more likely to remember words in the test if they had later practised them. Effect preceded cause.

Bem published his findings in the Journal of Personality and Social Psychology (JPSP) along with eight other experiments1 providing evidence for what he refers to as “psi”, or psychic effects. There is, needless to say, no shortage of scientists sceptical about his claims. Three research teams independently tried to replicate the effect Bem had reported and, when they could not, they faced serious obstacles to publishing their results. The episode served as a wake-up call. “The realization that some proportion of the findings in the literature simply might not replicate was brought home by the fact that there are more and more of these counterintuitive findings in the literature,” says Eric-Jan Wagenmakers, a mathematical psychologist from the University of Amsterdam.

Positive results in psychology can behave like rumours: easy to release but hard to dispel. They dominate most journals, which strive to present new, exciting research. Meanwhile, attempts to replicate those studies, especially when the findings are negative, go unpublished, languishing in personal file drawers or circulating in conversations around the water cooler. “There are some experiments that everyone knows don't replicate, but this knowledge doesn't get into the literature,” says Wagenmakers. The publication barrier can be chilling, he adds. “I've seen students spending their entire PhD period trying to replicate a phenomenon, failing, and quitting academia because they had nothing to show for their time.” |

| Zitat: | | In a survey of more than 2,000 psychologists, Leslie John, a consumer psychologist from Harvard Business School in Boston, Massachusetts, showed that more than 50% had waited to decide whether to collect more data until they had checked the significance of their results, thereby allowing them to hold out until positive results materialize. More than 40% had selectively reported studies that “worked”. On average, most respondents felt that these practices were defensible. “Many people continue to use these approaches because that is how they were taught,” says Brent Roberts, a psychologist at the University of Illinois at Urbana–Champaign. |

Konkrete Zahlen zu nicht replizierbaren Studien habe ich auch noch, aber wiederum wohl nicht mehr heute.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3628

|

(#1878801) Verfasst am: 03.11.2013, 18:50 Titel: (#1878801) Verfasst am: 03.11.2013, 18:50 Titel: |

|

|

| esme hat folgendes geschrieben: | | Der Grund, warum mich die Formulierung besonders geärgert hat, ist die Sache, dass du diesen Thread "geschlossen" formuliert hast. Du bringst hier eine durchaus interessante, aber relativ alte Meldung in etwas übertriebenem Stil und machst dann keinen Thread über Probleme in Studien oder über kulturellen Bias in der Wissenschaft oder so, sondern du bringst nur diese Meldung und öffnest im ersten Beitrag überhaupt nicht zu einer Diskussion, in die man auch andere Probleme einbringen könnte (medizinische studien nur an Männern, Reproduktion eines falschen physikalischen Wertes vermutlich ohne Betrug, usw.). |

Danke für die klaren Worte. Das schätze ich sehr.

Ich hätte im Eingangsbeitrag statt eines einzigen, dürren Satzes wohl ausführlicher sagen sollen, wo ich hin will. Oder ich hätte wenigstens um Geduld bitten sollen, bis ich all mein Material ausgebreitet habe und zu einem Fazit komme.

Nicht ganz nachvollziehen kann ich, warum du statt dich zu ärgern nicht einfach aufgeschrieben hast, was dir zum Thema einfällt.

| Kival hat folgendes geschrieben: | | Disclaimer: Faktisch bin ich bisher sicher auch "frequentist", ich kenne mich mit Bayesian statistics auch noch nicht wirklich gut aus [...] |

Den Nachsatz kaufe ich dir nicht ab.  Wahrscheinlich weißt du viel mehr über Statistik als ich. Wahrscheinlich weißt du viel mehr über Statistik als ich.

Das Problem dürfte eher sein, daß man kein Maß angeben kann dafür, welche Hypothese vernünftig ist. Außer man läßt intuitive Argumente zu - die sich schlecht quantifizieren lassen.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1878808) Verfasst am: 03.11.2013, 19:38 Titel: (#1878808) Verfasst am: 03.11.2013, 19:38 Titel: |

|

|

| smallie hat folgendes geschrieben: |

| Kival hat folgendes geschrieben: | | Disclaimer: Faktisch bin ich bisher sicher auch "frequentist", ich kenne mich mit Bayesian statistics auch noch nicht wirklich gut aus [...] |

Den Nachsatz kaufe ich dir nicht ab.  Wahrscheinlich weißt du viel mehr über Statistik als ich. Wahrscheinlich weißt du viel mehr über Statistik als ich. |

Nein, ich habe wirklich bisher kaum Berührungspunkte mit Bayesian Statistics gehabt. Die werden in den Sozialwissenschaften auch nicht wirklich gelehrt, zumindest ist es vor allem in Deutschland nicht sehr verbreitet. Erst über R und eine Einführung in die - komplexere Datenanalyse - von Gelman (und Hill) bin ich ernsthaft auf praktische Anwendung von Bayesian Statistics gestoßen. Und wirklich eingehend konnte ich mich mit mathematischer Statistik bisher auch nicht beschäftigen (vielleicht komme ich nächstes Semester wengistens dazu...)

| Zitat: | | Das Problem dürfte eher sein, daß man kein Maß angeben kann dafür, welche Hypothese vernünftig ist. Außer man läßt intuitive Argumente zu - die sich schlecht quantifizieren lassen. |

Schau dir die 5 Seiten von Gelman und Robert an, die dürften darauf eingehen, inwieweit Bayesian Statistics - ihrer Ansicht nach - durchaus anwendbar sind. Da geht es - meinem Überfliegen zufolge - nicht um technisch-mathematische Details.

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3628

|

(#1879135) Verfasst am: 04.11.2013, 23:25 Titel: Re: Wie relevant ist das? (#1879135) Verfasst am: 04.11.2013, 23:25 Titel: Re: Wie relevant ist das? |

|

|

| NoReply hat folgendes geschrieben: | Hallo,

stellt sich aber auch die Frage wie relevant das überhaupt ist. |

Für die Beispiele aus dem ersten Post war das schon relevant.

Insbesondere lagen die Weirdoes nicht einfach irgendwo auf der Ergebnisskala, sondern regelmäßig am Rand der Skala. Im Original sprechen die Autoren von Ausreißern outliers.

Zur Gesamtheit der Studien aus Psychologie/Soziologie/Verhaltensforschung kann ich nichts sagen. Aber zumindest alles was aus der Ecke Evolution/Moral/Gene-Culture-Co-Evolution kommt und ernst genommen werden will, greift auf Human Relations Area Files HRAF oder die World Values Survey zu oder präsentiert eigene vergleichende Daten.

Ja, wird versucht. Ganz am Ende dieses Bemühens steht die Aussicht auf eine "personalisierte Medizin".

Ich persönlich bin hier für die nächste Zukunft eher skeptisch, aber mangels Fachwissen über Medizin möchte ich mich nicht zu weit aus dem Fenster lehnen. Folgendes traue ich mich zu sagen: es reicht nicht, einen einzelnen Lokus zu betrachten, man muß das gesamte Genom betrachten. Es wird gerade versucht, eine Datenbank aufzubauen, die von jeder Bevölkerungsgruppe eine vollständige Genomsequenzierung von wenigstens tausend Individuen enthält.

Ioannidis sagt zum Thema dies - etwas salopp und verkürzt übersetzt:

| Zitat: | "[Das herkömmliche Signifikanzniveau von p = 0,05] war in der Vergangenheit hinnehmbar, als wenige Wissenschaftler wenige Analysen unternahmen. Heute allerdings führen Wissenschaftler millionen von Analysen durch, in jeder einzelnen Studie. Um falsch-positive Ergebnisse in der medizinischen Genetik zu vermeiden, sollte p bei mindestens 0,00000005 liegen."

[...]

Die neuen Standards führten zur Erkenntnis, daß viele genetische Faktoren ein Risiko nicht verdoppeln oder verdreifachen, der Faktor liegt eher bei 1,1 oder 1,5

http://now.tufts.edu/articles/man-who-did-math |

| Zitat: | “This means that if a single researcher runs 20 analyses, he or she will find one spurious—or false-positive–discovery by chance,” Ioannidis says. “This was quite tolerable in the past when there were fewer scientists running fewer analyses. However, now there are millions of scientists, some of whom run millions of analyses in each study they conduct. To avoid false-positive results in genetics, the current goal for a p value should be less than 0.00000005.” Many other fields should also become more stringent in their statistical criteria for claiming discoveries, he adds.

Along with more stringent statistical criteria, large consortia of up to 30 or more teams of investigators often are “joining forces with common protocols, common definitions, stringent quality control, sharing of all the data and a common analysis plan,” he says. Genetics research is a good example, as international groups of researchers sift through vast amounts of data to identify the genes that cause different diseases.

The new standards have led to a realization that many genetic factors don’t increase the risk of, say, having diabetes or a heart attack or Parkinson’s disease two-fold or three-fold, as previously thought. Instead, those risks work out to 1.1-fold or 1.15-fold. “These are far more tempered and conservative discoveries, but they are genuine,” he says. |

| NoReply hat folgendes geschrieben: | | Andere Studien haben von Anfang an nicht den Anspruch für die gesamte Menschheit zu gelten, sondern nur für ein bestimmtes Land. (z.B. Die Studie der Friedrich-Ebert-Stiftung zu Rechtsextremismus in Deutschland) |

Wenn man den Geltungsbereich mit angibt, dann passt das natürlich.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3628

|

(#1879136) Verfasst am: 04.11.2013, 23:27 Titel: (#1879136) Verfasst am: 04.11.2013, 23:27 Titel: |

|

|

| Kival hat folgendes geschrieben: | Relativ weit oben auf meiner Liste steht ansonsten folgender Artikel, vielleicht ist der ja für dich auch interessant. Ist zwar nur sehr kurz, aber ich hatte noch keine Zeit...

Gelman, Andrew, und Christian P. Robert. 2013. „“Not only defended but also applied”: The perceived absurdity of Bayesian inference“. The American Statistician 67 (1): 1–5.

Frei zugänglich unter: http://arxiv.org/pdf/1006.5366 |

Köstlich! Der Artikel hat einen sehr hohen Grinsekoeffizienten *g*.

| Zitat: | Recall the following principle, to which we (admitted Bayesians) subscribe:

| Zitat: | | Everyone uses Bayesian inference when it is clearly appropriate. A Bayesian is someone who uses Bayesian inference even when it might seem inappropriate. |

|

Oder:

| Zitat: | The sun’ll come out tomorrow

More than that, though, the big, big problem with the Pr(sunrise tomorrow

| sunrise in the past) argument is not in the prior but in the likelihood, which

assumes a constant probability and independent events. Why should anyone

believe that? Why does it make sense to model a series of astronomical events

as though they were spins of a roulette wheel in Vegas? Why does stationarity

apply to this series? That’s not frequentist, it isn’t Bayesian, it’s just dumb.

Or, to put it more charitably, it’s a plain vanilla default model that we should

use only if we are ready to abandon it on the slightest pretext. The Laplace law

of succession has been discussed ad nauseaum in relation to the Humean debate

about inference. |

Diese Humesche Debatte hatten wir gerade kürzlich erst im Naturalismus/Vollmer-Thread.

Das "doomsday argument" ist auch ein altbekanntes Paradox. Ich hab's nie recht verstanden. Die Auflösung im Artikel gefällt mir.

Überrascht war ich, wie umstritten Bayes in der Anwendung ist.  Aus meine Warte ist das nicht gerechtfertigt, weil Bayes an vielen Stellen auftritt. Aus meine Warte ist das nicht gerechtfertigt, weil Bayes an vielen Stellen auftritt.

In der KI bei inference engines von Expertensystemen.

| Zitat: | Fact: If someone has a cavity and no gum disease, there is a 60% chance they have a toothache.

Fact: If someone has gum disease and no cavities, there is a 30% chance they have a toothache.

Query: If somebody has a toothache, what is the chance they have a cavity?

http://cse3521.artifice.cc/bayesian-inference.html |

Fuzzy logic kann man auch bayesianisch lesen:

"Alt" bedeutet im Kontext von Kindergärten etwa 5 Jahre.

"Alt" bedeutet im Kontext von Altersheim 90+ Jahre

"Alt" bedeutet im Kontext von Humanpaläontologie 2 Mio. Jahre oder mehr.

Und last-not-least ist ein neuronales Netz - so wie unser Gehirn - genaugenommen nichts anderes als eine riesige Bayes-Maschine.

Allerdings bleibt einem, wenn man nach unbekannten Zusammenhängen sucht, erst mal nur der frequentistische Ansatz. Er hat also durchaus seine Berechtigung. Das stellt der Artikel recht schön dar.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

|