| Vorheriges Thema anzeigen :: Nächstes Thema anzeigen |

| Autor |

Nachricht |

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1885557) Verfasst am: 25.11.2013, 22:02 Titel: Interessante (neue) Veröffentlichungen (#1885557) Verfasst am: 25.11.2013, 22:02 Titel: Interessante (neue) Veröffentlichungen |

|

|

Hier können (neuere, muss aber nicht), interessante Veröffentlichungen (Studien, Theorien, usw.), die nicht unbedingt einen eigenen Thread wert sind, einfach kurz erwähnt werden (am besten mit Abstract/kurzer Zusammenfassung und einem frei zugänglichen Link falls möglich). Keine inhaltlichen Einschränkungen, es sollte aber schon irgendwas mit Wissenschaft zu tun haben  . .

Ich fange mal an mit einer Studie zum Einfluss der Einstellung zu Stress auf die Wirkung von Stress (leider ohne frei zugängliche Links):

Crum, Alia J, Peter Salovey, und Shawn Achor. 2013. „Rethinking stress: the role of mindsets in determining the stress response“. Journal of personality and social psychology 104 (4) (April): 716–733. doi:10.1037/a0031201.

http://www.ncbi.nlm.nih.gov/pubmed/23437923

| Zitat: | | This article describes 3 studies that explore the role of mindsets in the context of stress. In Study 1, we present data supporting the reliability and validity of an 8-item instrument, the Stress Mindset Measure (SMM), designed to assess the extent to which an individual believes that the effects of stress are either enhancing or debilitating. In Study 2, we demonstrate that stress mindsets can be altered by watching short, multimedia film clips presenting factual information biased toward defining the nature of stress in 1 of 2 ways (stress-is-enhancing vs. stress-is-debilitating). In Study 3, we demonstrate the effect of stress mindset on physiological and behavioral outcomes, showing that a stress-is-enhancing mindset is associated with moderate cortisol reactivity and high desire for feedback under stress. Together, these 3 studies suggest that stress mindset is a distinct and meaningful variable in determining the stress response. |

Und noch was lustiges:

Linthwaite, Sarah, und Geraint N. Fuller. 2013. „Milk, Chocolate and Nobel Prizes“. Practical Neurology 13 (1) (Januar 2): 63–63. doi:10.1136/practneurol-2012-000471.

http://pn.bmj.com/content/13/1/63.extract

| Zitat: | | In a recent paper Dr Messerli reported a strong correlation between a nation's chocolate consumption with the country's prowess in winning Nobel prizes per capita (see Carphology, in this issue). Messerli speculated that flavonoids within chocolate may contribute to this link by improving cognitive function—while recognising a correlation does not establish causation. However, chocolate is not usually consumed on its own, often being combined … |

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1885904) Verfasst am: 27.11.2013, 00:13 Titel: (#1885904) Verfasst am: 27.11.2013, 00:13 Titel: |

|

|

So einen Thread habe ich schon lange vermisst. Hier werde ich wohl öfter mal was schreiben.

Ein bisschen Künstliche Intelligenz.

Kurzfassung:

- komplexe neuronale Netzen zeigen ähnliche Eigenschaften wie Gehirne. Take that, Mr. Thomas Nagel.

- Schlaf/Traum scheint ähnlich zur Lernphase neuronaler Netze zu sein.

- Das Blue-Brain-Projekt in der Schweiz wird scheitern.

Verweise zu den Originalstudien im Link.

| Zitat: | As Machines Get Smarter, Evidence They Learn Like Us

Natalie Wolchover

July 23, 2013

[...]

If a picture of a car is fed into a neural network trained to detect specific objects in images, the lower layer fires if it detects a contrast, which would indicate an edge or endpoint. These neurons’ signals travel to high level neurons, which detect corners, parts of wheels, and so on. In the top layer, there are neurons that fire only if the image contains a car.

“The magic thing that happens is it’s able to generalize,” said Yann LeCun, director of the Center for Data Science at New York University. “If you show it a car it has never seen before, if it has some common shape or aspect to all the cars you showed it during training, it can determine it’s a car.”

Neural networks have recently hit their stride thanks to Hinton’s layer-by-layer training regimen, the use of high-speed computer chips called graphical processing units, and an explosive rise in the number of images and recorded speech available to be used for training. The networks can now correctly recognize about 88 percent of the words spoken in normal, human, English-language conversations, compared with about 96 percent for an average human listener. They can identify cars and thousands of other objects in images with similar accuracy and in the past three years have come to dominate machine learning competitions.

https://www.simonsfoundation.org/quanta/20130723-as-machines-get-smarter-evidence-they-learn-like-us/ |

Im Artikel wird viel von einer Boltzmann-Maschine gesprochen, aber das habe ich noch nicht verstanden und noch kein Bild dafür gefunden:

| Zitat: | | One of the most promising of these algorithms, the Boltzmann machine, bears the name of 19th century Austrian physicist Ludwig Boltzmann, who developed the branch of physics dealing with large numbers of particles, known as statistical mechanics. Boltzmann discovered an equation giving the probability of a gas of molecules having a particular energy when it reaches equilibrium. Replace molecules with neurons, and the Boltzmann machine, as it fires, converges on exactly the same equation. |

Nach allem was ich weiß, ist Schlaf für menschliches Lernen wesentlich. Die Analogie der Gewichtungsphase bei neuronalen Netzen zu nächtlichen Schlaf-Träumen lag für mich immer nahe - auch wenn sie sehr gewagt ist. Oder doch nicht?

| Zitat: | Neuroscientists have long known that sleep plays an important role in memory consolidation, helping to integrate newly learned information. In 1995, Hinton and colleagues proposed that sleep serves the same function as the baseline component of the algorithm, the rate of neural activity in the absence of input.

“What you’re doing during sleep is you’re just figuring out the base rate,” Hinton said. “You’re figuring out how correlated would these neurons be if the system were running by itself. And then if the neurons are more correlated than that, increase the weight between them. And if they’re less correlated than that, decrease the weight between them.” |

In der Schweiz wird gerade versucht, ein Rattengehirn zu simulieren. Ich möchte nicht unken, vermute aber, daß die dort nur einen epilleptischen Anfall simuleren werden, um es salopp zu sagen.

| Zitat: | The neural network approach to understanding the brain contrasts sharply with that of the Human Brain Project, Swiss neuroscientist Henry Markram’s much-hyped plan to create a precise simulation of a human brain using a supercomputer. Unlike Hinton’s approach of starting with a highly simplified model and gradually making it more complex, Markram wants to include as much detail as possible from the start, down to individual molecules, in hopes that full functionality and consciousness will emerge.

The project received $1.3 billion in funding from the European Commission in January, but Hinton thinks the mega-simulation will fail, mired by too many moving parts that no one yet understands. (Markram did not respond to requests for comment.) |

So, und jetzt muß ich noch lernen, wie ich sowas zukünftig kürzer zitiere.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1889509) Verfasst am: 09.12.2013, 13:40 Titel: (#1889509) Verfasst am: 09.12.2013, 13:40 Titel: |

|

|

http://www.nature.com/news/weak-statistical-standards-implicated-in-scientific-irreproducibility-1.14131

| Zitat: | | The plague of non-reproducibility in science may be mostly due to scientists’ use of weak statistical tests, as shown by an innovative method developed by statistician Valen Johnson, at Texas A&M University in College Station. |

Im Kontext der Debatte um die Schwierigkeiten, wissenschaftliche Studien zu reproduzieren, argumentiert Valen Johnson, dass das Problem die zu anspruchslosen Signifikanzniveaus sind. Er benutzt eine neue Variante Bayesianischer Tests, die eine direkte Vergleichbarkeit mit den üblichen frequentistischen Tests erlauben soll und zeigt, dass - ausgehend von 50 % korrekten Nullhypothesen - Alternativhypothesen bei dem Standard p-value von 0,05 zu zwischen 18 und 23 % fälschlicherweise als richtig angesehen werden. Dies entspricht wohl auch ungefähr der Größenordnung zu der Ergebnisse nicht repliziert werden können. Selbst ein P-Wert von 0,01 wäre noch zu schwach und er fordert einen neuen Standard von 0,005 (Johnson 2013, 4).

Johnson, Valen E. 2013. „Revised Standards for Statistical Evidence“. Proceedings of the National Academy of Sciences 110 (4 (November 26): 19313–19317. doi:10.1073/pnas.1313476110. (November 26): 19313–19317. doi:10.1073/pnas.1313476110.

http://www.pnas.org/content/110/48/19313

| Abstract hat folgendes geschrieben: | | "Recent advances in Bayesian hypothesis testing have led to the development of uniformly most powerful Bayesian tests, which represent an objective, default class of Bayesian hypothesis tests that have the same rejection regions as classical significance tests. Based on the correspondence between these two classes of tests, it is possible to equate the size of classical hypothesis tests with evidence thresholds in Bayesian tests, and to equate P values with Bayes factors. An examination of these connections suggest that recent concerns over the lack of reproducibility of scientific studies can be attributed largely to the conduct of significance tests at unjustifiably high levels of significance. To correct this problem, evidence thresholds required for the declaration of a significant finding should be increased to 25–50:1, and to 100–200:1 for the declaration of a highly significant finding. In terms of classical hypothesis tests, these evidence standards mandate the conduct of tests at the 0.005 or 0.001 level of significance." |

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1889675) Verfasst am: 09.12.2013, 23:03 Titel: (#1889675) Verfasst am: 09.12.2013, 23:03 Titel: |

|

|

| Kival hat folgendes geschrieben: | | Im Kontext der Debatte um die Schwierigkeiten, wissenschaftliche Studien zu reproduzieren, argumentiert Valen Johnson, dass das Problem die zu anspruchslosen Signifikanzniveaus sind. Er benutzt eine neue Variante Bayesianischer Tests, die eine direkte Vergleichbarkeit mit den üblichen frequentistischen Tests erlauben soll und zeigt, dass - ausgehend von 50 % korrekten Nullhypothesen - Alternativhypothesen bei dem Standard p-value von 0,05 zu zwischen 18 und 23 % fälschlicherweise als richtig angesehen werden. |

Yep. Über den Artikel bin ich auch gestolpert, hab's aber nicht geschafft, ihn hier anzubringen. Folgendes habe ich bisher auch noch nicht erwähnt:

In den statistischen Wissenschaften fehlt oft eine grundlegende Theorie. Zum Beispiel sind priming Experimente in der Psychologie gerade der letzte Schrei. Etwa derart: man legt Probanden Begriffe vor, wie "jung, behende" oder "alt, träge" und stellt dann fest, daß das ihre Gehgeschwindigkeit beeinflußt. Wenn man den Studien denn glaubt.

Nicht mehr ganz taufrisch dazu:

| Zitat: | Gibson’s ecological approach – a model for the benefits of a theory driven psychology

Sabrina Golonka and Andrew D Wilson

When particle physicists recently found that some neutrinos had apparently travelled faster than light (Adams et al. 2011) it never actually occurred to them that this is what had happened. On the basis of the extraordinarily well supported theory of relativity, the physics community went ‘that's weird - I wonder what we did wrong?’, and proceeded to use that theory to generate hypotheses they could then test. It would take a lot of fast neutrinos to disprove relativity, and even though the result turned out to be caused by a faulty cable, the robust response by physicists stands as an example of the benefits of a good theory.

Similarly, the core of modern biology is the theory of evolution. When creationists say ‘we can’t see how a bacterial flagellum which rotates like an outboard motor could possibly have evolved, it’s irreducibly complex’ (e.g. Dembski 2002), biologists are entitled to say ‘we have evidence that lots and lots of other things have evolved. Let’s see if we can figure out how the flagellum did it, and in the meantime, we’re going to operate on the assumption that it did evolve until we have strong evidence to the contrary’. The resulting theory driven empirical work then happily led to a coherent evolutionary story for the flagellum (e.g. Musgrave 2004).

Psychology has many individual theories describing isolated phenomena but no core theory of behaviour to guide our research, no analogue to the theories of relativity or evolution. This is beginning to cost the discipline. Recently Bem (2011) published a series of experiments purporting to demonstrate evidence of precognition. Bem took several standard psychological experiments and reversed the temporal ordering of the elements. [...] Because he followed the rules of experimental design and had statistically significant results, the Journal of Personality & Social Psychology was unable to find a reason to reject the paper. The editors only noted that “the reported findings conflict with our own beliefs about causality and that we find them extremely puzzling”

[...]

Psychology needs a core theory in order to mature as a science. Theory serves a dual role in science. It allows the scientist to identify when a result is likely to be anomaly (e.g. faster-than-light neutrinos), and, more critically, it provides a guide to discovery to structure the search for explanations of novel phenomena [...]

http://avant.edu.pl/wp-content/uploads/SGAW-Gibson-s-ecological-approach.pdf |

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1889700) Verfasst am: 10.12.2013, 00:21 Titel: (#1889700) Verfasst am: 10.12.2013, 00:21 Titel: |

|

|

Die Artikel von Bem zu Precognition haben interessanterweise ja auch eine Welle der Selbstkritik in der Psychologie und umfangreiche Überlegungen zum Replizieren in Gang gebracht. In der Politikwissenschaft gibt es ähnliche Tendenzen in letzter Zeit. Die Soziologie scheint da aber noch etwas hinterher zu sein.

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1891456) Verfasst am: 17.12.2013, 18:32 Titel: (#1891456) Verfasst am: 17.12.2013, 18:32 Titel: |

|

|

Aus der Kategorie, neue, aber höchstwahrscheinlich übertriebene Veröffentlichungen:

Dr. John Stamatoyannopoulos denkt, er und sein Team habe eine Art zweiten Code in der DNA gefunden. Der Rest der Fachwelt staunt ungläubig.

| Zitat: | Scientists discover double meaning in genetic code

Scientists have discovered a second code hiding within DNA. This second code contains information that changes how scientists read the instructions contained in DNA and interpret mutations to make sense of health and disease.

[...]

Since the genetic code was deciphered in the 1960s, scientists have assumed that it was used exclusively to write information about proteins. UW scientists were stunned to discover that genomes use the genetic code to write two separate languages. One describes how proteins are made, and the other instructs the cell on how genes are controlled. One language is written on top of the other, which is why the second language remained hidden for so long.

http://www.washington.edu/news/2013/12/12/scientists-discover-double-meaning-in-genetic-code/ |

Eine sehr deutliche Gegenaussage:

| Zitat: | Go home PR team, you're drunk.

So, statements like this one published today are just downright erroneous (italicised words are my emphases. Then I went further and underlined them as well):

“The second one [regulatory regions], which was just discovered, codes information which tells the cell how to control genes”

Hogwash!

Even the finding that these regulatory regions are embedded within protein-coding sequences is nothing new; they have been discovered in several studies since 1995. The main conclusions of this new study by Dr. John Stamatoyannopoulos and his colleagues is that these regions are more pervasively contained within coding-sequences than previously believed – 87% of genes (from the 81 cell types investigated) contained them.

http://www.bacteriatobonobos.com/1/post/2013/12/go-home-pr-team-youre-drunk.html |

Etwas sachlicher

| Zitat: | Don't Be Duped By 'Duon' DNA Hype

The hype began with the way hype often begins: an institutional news release offering us the holy grail/huge breakthrough/game-changing finding of the day. This kind of exaggeration is the big reason any science consumer should look well beyond the news release in considering new findings. A news release is a marketing tool. You’re reading an advertisement when you read a news release. In this case, the advertisement/news release not only goes off the rails with the hype, it’s also scientifically garbled and open to all kinds of misinterpretation, as the comments at the link to the release make clear.

Here’s some of the hype with a soupçon of garble.

| Zitat: | | Since the genetic code was deciphered in the 1960s, scientists have assumed that it was used exclusively to write information about proteins. UW scientists were stunned to discover that genomes use the genetic code to write two separate languages. |

Scientists have not assumed that the genetic code “was used exclusively to write information about proteins,” or even ever assumed that it “writes information about proteins,” whatever that means. A quick primer: Proteins are molecules that do the work of an organism, and that includes the work of copying DNA for protein production and cell division. Even nonmajors biology textbooks cover the fact that the DNA sequence both contains code for proteins and serves a regulatory purpose, [...]

http://www.forbes.com/sites/emilywillingham/2013/12/13/dont-be-duped-by-duon-dna-hype/ |

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1892593) Verfasst am: 21.12.2013, 22:13 Titel: (#1892593) Verfasst am: 21.12.2013, 22:13 Titel: |

|

|

Viel kann ich nicht zu dieser Meldung sagen, weil mir das zu hoch ist. Sieht aber interessant aus.

Eine neue Methode, die ein geometrisches Objekt namens Amplituhedron nutzt, erlaubt es, Ergebnisse von Partikelkollisionen viel einfacher zu berechnen als bisher. Allerdings geht das bisher nur mit einer supersymmetrischen Form der Yang-Mills-Theorie. Tja, SUSY ist wohl falsch. Nima Arkani-Hamed behauptet aber, die Methode sei auch für andere Quantenfeldtheorien geeignet.

| Zitat: | The Amplituhedron

Nima Arkani-Hamed, Jaroslav Trnka

(Submitted on 6 Dec 2013)

Perturbative scattering amplitudes in gauge theories have remarkable simplicity and hidden infinite dimensional symmetries that are completely obscured in the conventional formulation of field theory using Feynman diagrams. This suggests the existence of a new understanding for scattering amplitudes where locality and unitarity do not play a central role but are derived consequences from a different starting point. In this note we provide such an understanding for N=4 SYM scattering amplitudes in the planar limit, which we identify as ``the volume" of a new mathematical object--the Amplituhedron--generalizing the positive Grassmannian. Locality and unitarity emerge hand-in-hand from positive geometry.

http://arxiv.org/abs/1312.2007 |

Ein Hintergrund-Artikel:

| Zitat: | A Jewel at the Heart of Quantum Physics

[...]

Locality is the notion that particles can interact only from adjoining positions in space and time. And unitarity holds that the probabilities of all possible outcomes of a quantum mechanical interaction must add up to one. The concepts are the central pillars of quantum field theory in its original form, but in certain situations involving gravity, both break down, suggesting neither is a fundamental aspect of nature.

In keeping with this idea, the new geometric approach to particle interactions removes locality and unitarity from its starting assumptions. The amplituhedron is not built out of space-time and probabilities; these properties merely arise as consequences of the jewel’s geometry. The usual picture of space and time, and particles moving around in them, is a construct.

[...]

The amplituhedron itself does not describe gravity. But Arkani-Hamed and his collaborators think there might be a related geometric object that does. Its properties would make it clear why particles appear to exist, and why they appear to move in three dimensions of space and to change over time.

[...]

The 60-year-old method for calculating scattering amplitudes — a major innovation at the time — was pioneered by the Nobel Prize-winning physicist Richard Feynman. He sketched line drawings of all the ways a scattering process could occur and then summed the likelihoods of the different drawings. The simplest Feynman diagrams look like trees: The particles involved in a collision come together like roots, and the particles that result shoot out like branches. More complicated diagrams have loops, where colliding particles turn into unobservable “virtual particles” that interact with each other before branching out as real final products. There are diagrams with one loop, two loops, three loops and so on — increasingly baroque iterations of the scattering process that contribute progressively less to its total amplitude. Virtual particles are never observed in nature, but they were considered mathematically necessary for unitarity — the requirement that probabilities sum to one.

[...]

In 1986, it became apparent that Feynman’s apparatus was a Rube Goldberg machine.

To prepare for the construction of the Superconducting Super Collider in Texas (a project that was later canceled), theorists wanted to calculate the scattering amplitudes of known particle interactions to establish a background against which interesting or exotic signals would stand out. But even 2-gluon to 4-gluon processes were so complex, a group of physicists had written two years earlier, “that they may not be evaluated in the foreseeable future.”

Stephen Parke and Tomasz Taylor, theorists at Fermi National Accelerator Laboratory in Illinois, took that statement as a challenge. Using a few mathematical tricks, they managed to simplify the 2-gluon to 4-gluon amplitude calculation from several billion terms to a 9-page-long formula, which a 1980s supercomputer could handle. Then, based on a pattern they observed in the scattering amplitudes of other gluon interactions, Parke and Taylor guessed a simple one-term expression for the amplitude. It was, the computer verified, equivalent to the 9-page formula. In other words, the traditional machinery of quantum field theory, involving hundreds of Feynman diagrams worth thousands of mathematical terms, was obfuscating something much simpler.

A sketch of the amplituhedron representing an 8-gluon particle interaction. Using Feynman diagrams, the same calculation would take roughly 500 pages of algebra.

https://www.simonsfoundation.org/quanta/20130917-a-jewel-at-the-heart-of-quantum-physics/ |

Lance Dixon, frischgebackener Gewinner des Sakurai-Preises für Theretische Teilchenphysik meinte lakonisch:

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1892676) Verfasst am: 22.12.2013, 05:50 Titel: (#1892676) Verfasst am: 22.12.2013, 05:50 Titel: |

|

|

Uh, vielen Dank für diesen Hinweis! Ich verstehe kaum ein Wort, aber sehr, sehr interessant. Vor allem gerade für mich...

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1893616) Verfasst am: 27.12.2013, 22:26 Titel: (#1893616) Verfasst am: 27.12.2013, 22:26 Titel: |

|

|

Der Thread braucht ein paar mehr Graphiken.

Das Interessanteste zuerst: Untersuchung der Entscheidungen von 8 Richtern in 2 parole boards (parole = Haftaussetzung oder Bewährung). Ihre positiven Entscheidungen sinken mit der Dauer ihrer Arbeitsphase. Die Kreise im Graph stellen Beginn, erste Pause und zweite Pause dar.

| Zitat: | Extraneous factors in judicial decisions

Are judicial rulings based solely on laws and facts? Legal formalism holds that judges apply legal reasons to the facts of a case in a rational, mechanical, and deliberative manner. In contrast, legal realists argue that the rational application of legal reasons does not sufficiently explain the decisions of judges and that psychological, political, and social factors influence judicial rulings. We test the common caricature of realism that justice is “what the judge ate for breakfast” in sequential parole decisions made by experienced judges. We record the judges’ two daily food breaks, which result in segmenting the deliberations of the day into three distinct “decision sessions.” We find that the percentage of favorable rulings drops gradually from ≈65% to nearly zero within each decision session and returns abruptly to ≈65% after a break. Our findings suggest that judicial rulings can be swayed by extraneous variables that should have no bearing on legal decisions.

http://www.pnas.org/content/early/2011/03/29/1018033108.short |

Erstaunlich, falls sich das bestätigt. ...und es dürfte nur die Spitze des Eisberges von willkürlichen Entscheidungen sein.

Nochmal Replikation:

| Zitat: | Investigating variation in replicability: The “Many Labs” Replication Project

Description: We conducted replications of 13 effects in psychological science with 36 samples and more than 6000 participants. We examined heterogeneity in replicability across sample and setting.

https://osf.io/wx7ck/wiki/home/ |

Beschreibung:

| Zitat: | This internationally cooperative study replicated 13 major psychology effects from over seven decades of research using 36 studies and a total sample of 6,344.

The x-axis shows the standardized mean difference between the control and treatment group so the interpretation is that the further rightwards the dots are, the stronger the effect is. The blue X is the strength of the effect in the original paper. Eleven of the 13 effects seem to be robust, particularly the anchoring studies which replicate much stronger effects than the original papers. The priming studies did not replicate the effect.

http://economicspsychologypolicy.blogspot.ie/2013/12/the-15-best-behavioural-science-graphs.html |

Priming-Versuche hatte ich oben schon erwähnt. Die Erwähnung eines Begriffes soll Entscheidungen oder Verhalten beeinflussen.

Anchoring ist sowas:

| Zitat: | Ankerheuristik (engl. anchoring effect) ist ein Begriff aus der Kognitionspsychologie für die Tatsache, dass Menschen bei bewusst gewählten Zahlenwerten von momentan vorhandenen Umgebungsinformationen beeinflusst werden, ohne dass ihnen dieser Einfluss bewusst wird. Die Umgebungsinformationen haben Einfluss selbst dann, wenn sie für die Entscheidung eigentlich irrelevant sind. Es handelt sich also um eine Urteilsheuristik, bei der sich das Urteil an einem willkürlichen „Anker“ orientiert. Die Folge ist eine systematische Verzerrung in Richtung des Ankers.

http://de.wikipedia.org/wiki/Ankerheuristik |

Interessant finde ich, daß anchoring letztlich eine Art priming mit Zahlen ist. Die Ergebnisse deuten darauf hin, daß Zahlenverständnis etwas anderes ist als Begriffsverständnis. Nicht neu, aber hier schön illustriert.

Hmm, falls das stimmt, könnte man es bei Gehaltsverhandlungen ausnutzen!?  Also nicht weitersagen... Also nicht weitersagen...

Zur Psychologie von Verkaufspreisen: angefangene 10 000er-Kilometerstände (bzw. Meilenstände, in diesem Fall) reduzieren den Verkaufspreis von gebrauchten Autos signifikant:

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

step

registriert

Anmeldungsdatum: 17.07.2003

Beiträge: 22782

Wohnort: Germering

|

(#1893627) Verfasst am: 27.12.2013, 23:16 Titel: (#1893627) Verfasst am: 27.12.2013, 23:16 Titel: |

|

|

| smallie hat folgendes geschrieben: | | Eine neue Methode, die ein geometrisches Objekt namens Amplituhedron nutzt, erlaubt es, Ergebnisse von Partikelkollisionen viel einfacher zu berechnen als bisher. ... |

Hab gestern auch mal reingeschaut - das ist schon ziemlich cool - und danke für den Blog-link, in dem der Autor u.a. selbst Fragen beantwortet.

Ich verstehe zwar noch ansatzweise, wie die Yang-Mills-Theorie funktioniert, aber hier muß ich auch passen. Von der Herleitung sieht es seriös aus und macht Sinn, was Dixon schreibt.

_________________

Was ist der Sinn des Lebens? - Keiner, aber Leere ist Fülle für den, der sie sieht.

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1893646) Verfasst am: 28.12.2013, 05:50 Titel: (#1893646) Verfasst am: 28.12.2013, 05:50 Titel: |

|

|

Step, weißt Du, ob es eine Besonderheit dieser Lösung ist, dass Lokalität und Unitarität als emergente Phänomene beschrieben werden können? Das scheint ja schon etwas mit dem Ganzen zu tun zu haben, aber ich habe nicht ganz verstanden, ob das diese Lösung mit ausmacht. Oder ist es so, dass das auch im ursprünglichen Ansatz bereits so war, der aber eben entsprechend aufwendig war bei der Formel usw.?

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

step

registriert

Anmeldungsdatum: 17.07.2003

Beiträge: 22782

Wohnort: Germering

|

(#1893672) Verfasst am: 28.12.2013, 12:43 Titel: (#1893672) Verfasst am: 28.12.2013, 12:43 Titel: |

|

|

| Kival hat folgendes geschrieben: | | Step, weißt Du, ob es eine Besonderheit dieser Lösung ist, dass Lokalität und Unitarität als emergente Phänomene beschrieben werden können? Das scheint ja schon etwas mit dem Ganzen zu tun zu haben, aber ich habe nicht ganz verstanden, ob das diese Lösung mit ausmacht. |

In der Tat, es ist nicht neu, aber wesentlich. Man vermutet (oder weiß) ja bereits, daß es nicht funktioniert, wenn man Lokalität und Unitarität einfach voraussetzt, da man dann die Widersprüche erhält, die Gravitation und QFT unvereinbar machen. Also muß man eine Lösung suchen, die L und U für bestimmte Parameterbereiche produziert - und das ist bei diesem Vorschlag erfreulicherweise der Fall.

| Kival hat folgendes geschrieben: | | Oder ist es so, dass das auch im ursprünglichen Ansatz bereits so war, der aber eben entsprechend aufwendig war bei der Formel usw.? |

Wenn man von einer "klassischen" QFT ausgeht, ist die immer axiomatisch unitär, grob gesagt ist die Unitarität in der Schrödingergleichung enthalten - und damit auch in den Feynman-Diagrammen usw.). Erst neuere Ansätze, z.B. Stringtheorien, versuchen das zu vermeiden. Allerdings waren die bisher alle entweder stark unterbestimt oder zu aufwendig zu berechnen.

_________________

Was ist der Sinn des Lebens? - Keiner, aber Leere ist Fülle für den, der sie sieht.

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1894354) Verfasst am: 31.12.2013, 13:08 Titel: (#1894354) Verfasst am: 31.12.2013, 13:08 Titel: |

|

|

Danke step.

@smallie

Auch danke für die weiteren Studien. Komme nur eingeschränkt dazu, es mir anzuschauen, ist aber sehr interessant. Im Prinzip auf eine Replikation, wurde hier mit neueren Methoden eine Analyse eines Lehrers über Freundschaftsnetzwerke aus dem jahr 1880 bestätigt.

Als weitere - wie ich finde sehr interssante - Studie aus dem Bereich der Netzwerkforschung:

Heidler, Richard, Markus Gamper, Andreas Herz, und Florian Eßer. 2014. „Relationship patterns in the 19th century: The friendship network in a German boys’ school class from 1880 to 1881 revisited“. Social Networks 37 (Mai): 1–13. doi:10.1016/j.socnet.2013.11.001.

http://www.sciencedirect.com/science/article/pii/S0378873313000865

| Zitat: | | The article presents a friendship network from 1880 to 1881 in a school class, which goes back to the exceptional mixed-methods study of the German primary school teacher Johannes Delitsch. The re-analysis of the historic network gives insights into what characteristics defined the friendship networks in school classes in Germany at the end of the 19th century. ERGMs of the so far unmarked data show structural patterns of friendship networks similar to today (reciprocity, transitive triadic closure). Moreover we test the influence of the class ranking order (Lokationsprinzip), which allocates the pupils in the class room according to their school performance. This ranking order produces a hierarchy in the popularity of pupils, through hierarchy–congruent friendship ties going upwards in the hierarchy. In this respect, concerning the effect of school achievement on popularity, we find a strong stratification, which is not always prevalent today. |

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1898563) Verfasst am: 23.01.2014, 22:42 Titel: (#1898563) Verfasst am: 23.01.2014, 22:42 Titel: |

|

|

Eine Überraschung - und perfektes Material für Spekulation.

Leben auf der Kriechspur: der Metabolismus von Primaten läuft nur halb so schnell wie bei anderen Säugetieren.

Durch Gabe von "markiertem Wasser" (Deuterium und Sauerstoff-18 ) haben Pontzer und Kollegen festgestellt, daß Primaten nur halb soviel Energie verbrauchen wie andere Säugetiere.

| Zitat: | Life in the slow lane: Primate metabolisms run at half the pace of other mammals

22 January 2014

Pontzer and colleagues compared metabolic rates between primates and other placental mammals, and found that primates (including humans) use actually use only half as much energy per day as similarly sized, non-primate mammals [...]

Pontzer and colleagues’ approach highlights an often-overlooked flaw in society’s obsession with metabolism: many online "health" calculators, personal trainers, and even doctors base recommended daily energy intake on your basal metabolic rate (BMR), which is an estimate of the number of calories your body spends just to keep itself alive in a given day—it doesn’t include any movement, growing, healing from wounds, or the costs of reproduction for adults.

This focus on BMR may be misguided. [...] Pontzer and colleagues point out that total energy expenditure (TEE) is what actually drives our lifestyles, in terms of acquiring energy, how our bodies allocate their energy budgets, and cellular senescence due to the production of free radicals from metabolic activity. Also, the authors point out that BMR accounts for less than half of the TEE for most mammalian species. BMR alone doesn’t give us much information about the daily energy requirements and expenditures of an animal, leaving us unable to predict how much energy remains available for growth and reproduction—keys to success in the evolutionary scheme of things.

The results were striking: the mean TEE of primates was 50.4% of that expected for their body mass. [...]

Comparing TEE between captive and wild populations of the same species allowed the researchers to discern whether daily activity level or a deeper metabolic mechanism is behind primates’ low TEE values. The data showed that wild primate populations had TEEs about 20% higher than their captive counterparts. This is not trivial, but still doesn’t account for the much broader difference in TEE between primates and non-primate mammals. Pontzer and colleagues claim that this shows that the low TEE of primates isn’t a result of less physical activity overall, but rather a “systemic reduction in cellular metabolism.”

http://www.scilogs.com/endless_forms/2014/01/22/life-in-the-slow-lane-primates-have-significantly-slower-metabolic-rates-than-other-mammals/ |

Nach dem letzten Absatz würde ich die 50% nicht mehr wörtlich nehmen, sie scheinen einer journalistischen Überhöhung geschuldet. Das Resultat erscheint mir dennoch verblüffend. Die Autoren behaupten, daß die gesparte Energie bei Menschen aus dem Stamm der Hazda einer täglichen Laufleistung von 45 km entspricht.

Das lädt zu Mutmaßungen ein, warum das so ist.

| Zitat: | | This leaves us with an overarching question: why so slow, primates? The authors point out that not only do primates’ cellular metabolic processes lumber along relatively slowly, but their (and our) entire lives move at a leisurely pace relative to other mammals: primates grow and mature slowly, reproduce slowly, and acquire life skills and social status slowly. Instead of taking the “live fast and die young” approach of many other mammals, primates’ relatively long lives afford them the luxury of plodding along. |

Ehrlich gesagt erscheint mir das Ganze so unplausibel, daß ich es gar nicht glauben mag. Gut: wer weniger Energie verbraucht, kann sich ein größeres Gehirn leisten. Aber warum ein großes Gehirn wie bei uns Menschenaffen den Zusammenhang nicht stört, verstehe ich nicht. Falls die Sache stimmt, könnte es ein interessantes Puzzlestück sein in der Evolution des Menschen.

Hmm.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

Darwin Upheaval

Evo-Devo-Darwinist & Wissenschaftskommunikator

Anmeldungsdatum: 23.01.2004

Beiträge: 5491

Wohnort: Tief im Süden

|

(#1898674) Verfasst am: 24.01.2014, 15:59 Titel: (#1898674) Verfasst am: 24.01.2014, 15:59 Titel: |

|

|

| smallie hat folgendes geschrieben: | Eine Überraschung - und perfektes Material für Spekulation.

Leben auf der Kriechspur: der Metabolismus von Primaten läuft nur halb so schnell wie bei anderen Säugetieren.

Durch Gabe von "markiertem Wasser" (Deuterium und Sauerstoff-18 ) haben Pontzer und Kollegen festgestellt, daß Primaten nur halb soviel Energie verbrauchen wie andere Säugetiere. |

Das ist vermutlich ein Grund, warum wir so alt werden. Säuger mit raschem Stoffwechsel sterben früh, weil sich die Zellen rascher teilen. Am sparsamsten mit seiner Energie geht der Orang-Utan um, nur Faultiere benötigen noch weniger...

http://www.spiegel.de/wissenschaft/natur/sparsamer-kalorienverbrauch-orang-utans-leben-am-energielimit-a-709759.html

| smallie hat folgendes geschrieben: | | [...] Ehrlich gesagt erscheint mir das Ganze so unplausibel, daß ich es gar nicht glauben mag. |

Ist so. Manche vermuten, das sei eine Anpassung an tendenziell knappe Ressourcen. Vielleicht liegt es auch daran, dass Primatenbabys noch sehr unreif sind und eine lange elterliche Betreuung benötigen. (In Umkehrung eines Slogans der Life-History-Theorie: "live slow, die old"). Fragt sich, was Ursache ist und was Wirkung.

| smallie hat folgendes geschrieben: |

Gut: wer weniger Energie verbraucht, kann sich ein größeres Gehirn leisten. |

Nein, es ist genau umgekehrt. Am meisten Energie verbrät der Körper für das Beheizen des Hirns, das als einziges Organ außerhalb der Körperhöhle liegt. Deshalb verbrauchen die Menschen von allen Primaten am meisten Energie.

| smallie hat folgendes geschrieben: |

Aber warum ein großes Gehirn wie bei uns Menschenaffen den Zusammenhang nicht stört, verstehe ich nicht. |

Möglicherweise ist ein Grund der, dass Primaten, verglichen mit anderen Großsäugern, relativ wenig Muskulatur besitzen. Das spart Energie. Zudem weist ihr Körper, im Vergleich zu Kleinsäugern, ein geringes Oberflächen/Volumen-Verhältnis auf. Die Spitzmaus hat, bezogen aufs Körpergewicht, einen viel größeren Energieumsatz, weil sie klein ist und daher rascher auskühlt.

_________________

"Science is a candle in the dark." - Carl Sagan

www.ag-evolutionsbiologie.de

www.facebook.com/AGEvolutionsbiologie

|

|

| Nach oben |

|

|

kereng

Privateer

Anmeldungsdatum: 12.12.2006

Beiträge: 3052

Wohnort: Hamburg

|

(#1898861) Verfasst am: 25.01.2014, 11:16 Titel: (#1898861) Verfasst am: 25.01.2014, 11:16 Titel: |

|

|

| smallie hat folgendes geschrieben: | | Aber warum ein großes Gehirn wie bei uns Menschenaffen den Zusammenhang nicht stört, verstehe ich nicht. |

Man kann ja einfach mehr oder anders essen. Jeder hat bestimmt schon von der Idee gehört, dass die Zubereitung der Nahrung das energiefressende Gehirn ermöglichte. Das Kochen ersetzt demnach einen aufwendigen Teil der Verdauung und liefert die Nährstoffe in leicht verfügbarer Form. Eine Quelle weiß ich nicht, aber Google liefert bestimmt was.

Nun müsste man zur Beurteilung dieser Idee noch wissen, wie Kochen und Gehirnvergrößerung zeitlich aufeinander folgten. Man kann einem Bobobo den Umgang mit Feuer beibringen. Habe gerade keine Zeit, sonst würde ich kurz die ältesten Hinweise auf Kochen oder Grillen recherchieren.

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1898862) Verfasst am: 25.01.2014, 11:47 Titel: (#1898862) Verfasst am: 25.01.2014, 11:47 Titel: |

|

|

x-post

Hoppla! Die Idee ist also nicht neu und mein Post kommt drei Jahre zu spät.

Das habe ich damals verpasst. Sogar der Autor ist der gleiche. Danke für den Hinweis.

Neu ist nur, daß nun mehrere Arten untersucht wurden.

| Darwin Upheaval hat folgendes geschrieben: | | smallie hat folgendes geschrieben: | | Leben auf der Kriechspur: der Metabolismus von Primaten läuft nur halb so schnell wie bei anderen Säugetieren. |

Das ist vermutlich ein Grund, warum wir so alt werden. Säuger mit raschem Stoffwechsel sterben früh, weil sich die Zellen rascher teilen. |

Da gibt es diese alte These:

| Zitat: | Heartbeat hypothesis

In 1926 Raymond Pearl proposed that longevity varies inversely with basal metabolic rate (the "rate of living hypothesis"). Support for this hypothesis comes from the fact that mammals with larger body size have longer maximum life spans and the fact that the longevity of fruit flies varies inversely with ambient temperature.

[...]

However, the ratio of resting metabolic rate to total daily energy expenditure can vary between 1.6 to 8.0 between species of mammals.

http://en.wikipedia.org/wiki/Heartbeat_hypothesis |

Manchmal wird sogar ein Zahl von rund zwei Milliarden Herzschlägen genannt.

Ich weiß nicht genau, was ich davon halten soll.

| Darwin Upheaval hat folgendes geschrieben: | | Manche vermuten, das sei eine Anpassung an tendenziell knappe Ressourcen. Vielleicht liegt es auch daran, dass Primatenbabys noch sehr unreif sind und eine lange elterliche Betreuung benötigen. (In Umkehrung eines Slogans der Life-History-Theorie: "live slow, die old"). Fragt sich, was Ursache ist und was Wirkung. |

Ich tippe nach wie vor auf:

| Darwin Upheaval hat folgendes geschrieben: | | smallie hat folgendes geschrieben: |

Gut: wer weniger Energie verbraucht, kann sich ein größeres Gehirn leisten. |

Nein, es ist genau umgekehrt. Am meisten Energie verbrät der Körper für das Beheizen des Hirns, das als einziges Organ außerhalb der Körperhöhle liegt. |

Das war schon richtig.

Der Gesamtverbrauch eines Lebewesens sei 1, davon braucht der Körper den Anteil k und das Gehin g, also k + g = 1.

Wer weniger Energie k verbraucht, kann sich ein größeres Gehirn g leisten. Ohne etwas dafür tun zu müssen. (!)

| Darwin Upheaval hat folgendes geschrieben: | | Deshalb verbrauchen die Menschen von allen Primaten am meisten Energie. |

Richtig.

| Darwin Upheaval hat folgendes geschrieben: |

| smallie hat folgendes geschrieben: |

Aber warum ein großes Gehirn wie bei uns Menschenaffen den Zusammenhang nicht stört, verstehe ich nicht. |

Möglicherweise ist ein Grund der, dass Primaten, verglichen mit anderen Großsäugern, relativ wenig Muskulatur besitzen. Das spart Energie. |

Über den relativen Muskelanteil weiß ich nichts. Baumbewohnende Lebewesen stelle ich mir grundsätzlich zierlicher vor als Bodenbewohner. Gorillas aber wären ein Gegenbeispiel.

(Was du mit Großsäugern sagen wolltest, habe ich nicht verstanden, weil manche Primaten recht klein sind, 500 g bis hinunter zu 50 g. OK, das ist immer noch eine Größenordnung mehr, als Zwergmäuse.)

Eine andere Möglichkeit, warum die Energieumsatz von Primaten nach Entwicklung des Gehirns nicht wieder steigt auf das übliche Säugetierniveau.: ein hochentwickeltes Gehirn braucht eine stetige Versorgung. Körpergewicht, Muskeln, Fett kann bei anderen Tieren in Zeiten von Hunger und Nahrungsmittelknappheit schwinden. Gehirnmasse ist kein derartiger Speicher, deshalb ist Sparflamme angesagt.

Noch eine andere Möglichkeit. Oben sagtest du: rascher Stoffwechsel, früher Tod. Ein früher Tod ist aber schlecht für ein Gehirn, das lernen kann. So manche Primatenart hat rudimentäre Formen von Kultur. Die Primaten würden sich den Ast absägen, auf dem sie sitzen, wenn sie ihre Stoffwechselrate nur wieder hochschraubten.

Uff, das war jetzt eine ganze menge, ganz wilde Spekulation.

| Darwin Upheaval hat folgendes geschrieben: | | Zudem weist ihr Körper, im Vergleich zu Kleinsäugern, ein geringes Oberflächen/Volumen-Verhältnis auf. Die Spitzmaus hat, bezogen aufs Körpergewicht, einen viel größeren Energieumsatz, weil sie klein ist und daher rascher auskühlt. |

Dein allometrisches Argument mit Oberfläche/Volumen stimmt natürlich grundsätzlich. Die Skala des obigen Charts ist doppelt logarithmisch, das weißt auf ein allometrisches Potenzgesetz hin. (Hier: Energieverbrauch ist die vierte Wurzel aus der dritten Potenz der Körpermasse.)

Aber wo kommt der Unterschied zwischen den beiden Geraden her? Ist es der Körperbau, der den Unterschied macht? Ich denke nicht. Mäuse und Elefanten sind in grober Näherung sogar noch kugelförmig, währen Primaten zu schlauchförmigem Körper mit langen, abstehenden Gliedmaßen tendieren. Eigentlich sollten Primaten schlechter wegkommen.

Bleibt eigentlich nur ein effizienterer Metabolismus.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1898873) Verfasst am: 25.01.2014, 13:18 Titel: (#1898873) Verfasst am: 25.01.2014, 13:18 Titel: |

|

|

| kereng hat folgendes geschrieben: | | smallie hat folgendes geschrieben: | | Aber warum ein großes Gehirn wie bei uns Menschenaffen den Zusammenhang nicht stört, verstehe ich nicht. |

Man kann ja einfach mehr oder anders essen. Jeder hat bestimmt schon von der Idee gehört, dass die Zubereitung der Nahrung das energiefressende Gehirn ermöglichte. Das Kochen ersetzt demnach einen aufwendigen Teil der Verdauung und liefert die Nährstoffe in leicht verfügbarer Form. Eine Quelle weiß ich nicht, aber Google liefert bestimmt was. |

"uns Menschenaffen" war ganz schlecht formuliert. Gemeint war nicht nur der Mensch, sondern alle great apes.

Ich hab' mich gefragt, warum Menschenaffen keine Ausreißer sind im Graph? Sie sollten sich "intellektuell" noch einmal vom Rest der Primaten abheben, ohne bei der Nahrungsbeschaffung wesentlich mehr Möglichkeiten zu haben.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1912626) Verfasst am: 30.03.2014, 01:31 Titel: (#1912626) Verfasst am: 30.03.2014, 01:31 Titel: |

|

|

Einer der schönsten Artikel, über die ich je gestolpert bin. Gefällt mir, weil er Überlegungen zu Populationsdynamik nutzt, um anthropologische Thesen zu beantworten. Er geht der Frage nach, warum die Landwirtschaft erst im Holozän entstanden ist.

Leider ist das nicht meine Ecke, deshalb kann ich nicht sagen, ob das Standardmeinung ist oder Außerseiteransicht. Den Artikel zur Geschichte der Landwirtschaft im aktuellen Spektrum der Wissenschaft fand ich im Vergleich nicht so erhellend.

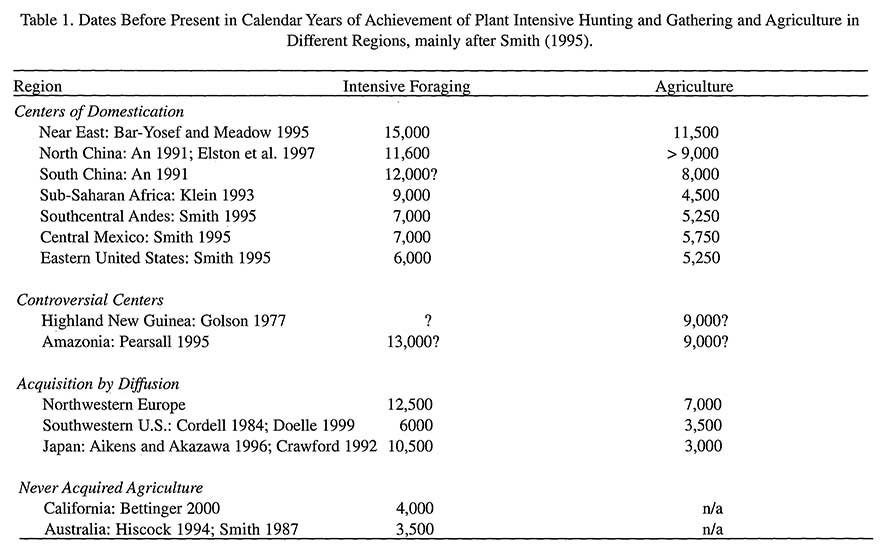

Die Entwicklung der Landwirtschaft eignet sich als Test für Thesen zur Verbreitung von Kultur, weil sie unabhängig voneinander mehrfach stattgefunden hat. Somit hat man mehrere Daten, an denen man eine These zu kultureller Evolution überprüfen kann. Hier der historische Ablauf:

Warum ist Landwirtschaft nicht schon früher entwickelt worden? Die Autoren greifen insbesondere diese These an: Landwirtschaft sei durch steigenden Bevölkerungsdruck "erzwungen" worden.

| Zitat: | Population Growth Has Wrong Time Scale.

Cohen’s (1977) influential book argued that slowly accumulating global-scale population pressure was responsible for the eventual origins of agriculture beginning at the 11,600 B.P. time horizon. He imagines, quite plausibly, that subsistence innovation is driven by increases in population density, but, implausibly we believe, that a long, slow buildup of population gradually drove people to intensify subsistence systems to relieve shortages caused by population growth, eventually triggering a move to domesticates. |

Ihre Argumentation hat drei Kernpunkte.

Klima zu variabel.

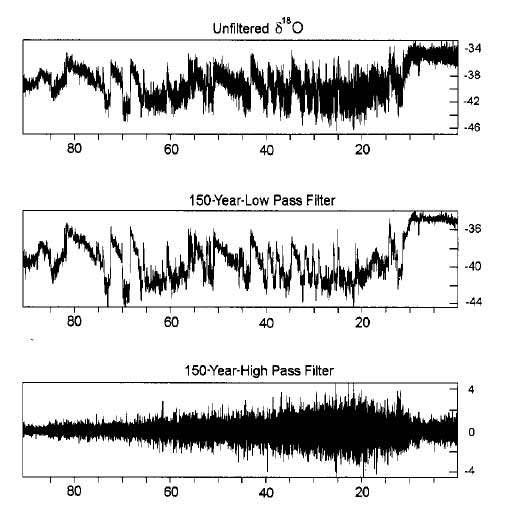

Die Autoren geben Beispiele für heutige Ernteausfälle durch Klimaextreme. Dann zeigen sie, daß das Klima im Pleistozän wesentlich größeren Schwankungen unterlag. Landwirtschaft wäre keine verlässliche Lebensgrundlage gewesen.

| Zitat: |

Figure 2. High resolution analysis of the GRIP ice core d18O data by Ditlevsen, et al. (1996). The low pass filtered data shows that the Holocene is much less variable than the Pleistocene on time scales of 150 years and longer. The high pass filtered data shows that the Pleistocene was also much more variable on time scales less that 150 years. The high and low pass filtering used spectral analytic techniques. These are roughly equivalent to taking a 150 year moving average of the data to construct the low pass filtered series and subtracting the low pass filtered series from the original data to obtain the high pass filtered record. Since diffusion increasingly affects deeper parts of the core by averaging variation on the smallest scales, the high pass variance is reduced in the older parts of the core. In spite of this effect, the Pleistocene/Holocene transition is very strongly marked. |

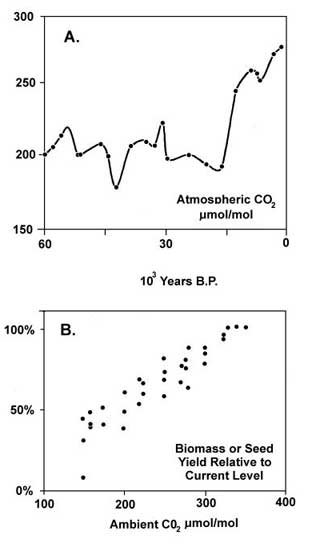

CO2-Gehalt zu niedrig.

Der CO2-Gehalt in der Atmosphäre war im Pleistozän zu niedrig für Landwirtschaft. Ernteerträge hängen vom CO2-Gehalt ab.

| Zitat: |

Figure 3. Panel a shows the curve of atmospheric CO2 as estimated from gas bubbles trapped in Antarctic glacial ice. Data from Barnola et al. (1987). Panel b summarizes responses of several plant species to experimental atmospheres containing various levels of CO2. Based on data summarized by Sage (1995). |

Meiner Ansicht nach ist es geschummelt, wenn man Achsen beschneidet.

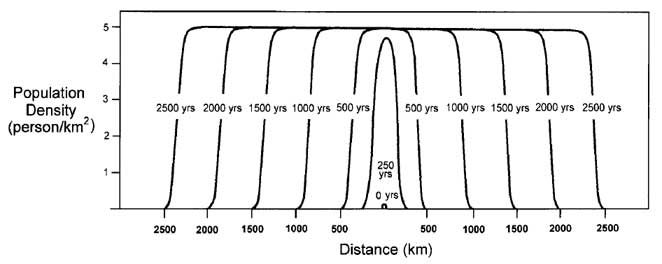

Bevölkerungsdynamik passt nicht zu Zeiträumen.

Boyd, Richerson und Bettinger nutzen eine 80 Jahre alte Differentialgleichung von R. A. Fischer, die die Ausbreitung von nützlichen Genen in einer Population beschreibt. Damit schätzen sie ab, wie schnell eine Bevölkerung in Richtung Tragkapazität wächst, nachdem neue Nahrungsquellen erschlossen werden.

Ihr Ergebnis: wegen der exponentiellen Natur von Wachstumsprozessen geht das recht schnell.

| Zitat: | | Once, after listening to one of us propound this argument, a skeptical archaeologist replied, “But you’ve got to fill up all of Asia, first.” This understandable intuitive response betrays a deep misunderstanding of the time-scales of exponential growth. Suppose that the initial population of anatomically modern humans was only about 10^4 and that the carrying capacity for hunter-gatherers is very optimistically 1 person per square kilometer. Given that the land area of the Old World is roughly 10^8 km², p0 = 10^4/10^8 = 10^–4. Then using equation 2 and again assuming r = 0.01, Eurasia will be filled to 99% of carrying capacity in about 1400 years. The difference between increasing population pressure by a factor of 100 and by a factor of 10,000 is only about 500 years! |

Die Zusammenfassung überlasse ich den Autoren:

| Zitat: | Nonetheless, we propose that much about the origin of agriculture can be understood in terms of two propositions:

Agriculture was impossible during the last glacial. During the last glacial, climates were variable and very dry over large areas. Atmospheric levels of CO2 were low. Probably most important, last glacial climates were characterized by high-amplitude fluctuations on time-scales of a decade or less to a millennium. Because agricultural subsistence systems are vulnerable to weather extremes, and because the cultural evolution of subsistence systems making heavy, specialized, use of plant resources occurs relatively slowly, agriculture could not evolve.

In the long run, agriculture is compulsory in the Holocene. In contrast to the Pleistocene, stable Holocene climates allowed the evolution of agriculture in vast areas with relatively warm, wet climates, or access to irrigation. Prehistoric populations tended to grow rapidly to the carrying capacity set by the environment and the efficiency of the prevailing subsistence system. Local communities that discover or acquire more intensive subsistence strategies will increase in number and exert competitive pressure on smaller populations with less intensive strategies. Thus, in the Holocene, such inter-group competition generated a competitive ratchet favoring the origin and diffusion of agriculture. |

Insbesondere zum CO2-Argument würde ich gerne Gegenargumente hören.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

kereng

Privateer

Anmeldungsdatum: 12.12.2006

Beiträge: 3052

Wohnort: Hamburg

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1914051) Verfasst am: 05.04.2014, 14:55 Titel: (#1914051) Verfasst am: 05.04.2014, 14:55 Titel: |

|

|

Folgendes ist schon alt. Originalquelle habe ich nicht, die kostet.

Versuchspersonen wurde eine zufällige Folge von roten oder blauen Karten gezeigt. 70% der Karten waren blau, 30% rot. Die Versuchspersonen durften auf das Erscheinen einer Farbe wetten. In 70% ihrer Wetten setzten sie auf blau. Es entging ihnen, daß ihr Wettmuster nicht mit der beobachteten Folge von Karten übereinstimmen mußte. In jeder Runde ist blau die wahrscheinlichste Wahl. Die beste Strategie ist nicht, meist blau zu wetten, sondern ständig.

| Zitat: | Information versus reward in binary choices.

Tversky A, Edwards W.. 1966

Subjects were shown a succession of cards, each card either red or blue. 70% of the cards were blue, and 30% red; the color sequence was random. The subjects, asked to bet on each succeeding card, would guess blue around 70% of the time, and red about 30% of the time. They didn't realize that their betting pattern did not have to resemble the observed sequence of cards. On each round, blue is the most likely next card. The best strategy is not betting a mostly-blue pattern resembling the mostly-blue sequence, but betting all blue. |

Der erstbeste Googletreffer, von dem das Zitat stammt, fährt mit einigen interessanten Überlegungen fort:

| Zitat: | Good Forecasts Will Strike Most People as Too Simple

Under conditions of uncertainty, your optimal forecast pattern doesn't resemble a typical sequence, because optimally you should assume every random disturbance equals zero, when we know it will actually be merely distributed around zero.

Probabilistically, the more detail, the more unlikely; in practice, convincing scenarios have a lot of specificity, like a good novel. But novels are fiction, and the future is not. Thus, 4 variable Vector-Auto-Regressions outdo 400-equation macro models, and default models with 4 inputs out-do CFA worksheets that examine 50 different accounting ratios. This is obviously non-intuitive, not natural, as demonstrated by Tversky and Edwards, but also if you look at the standard tools to evaluate credit risk which give you so much information.

Thus, paradoxically, a good model should be a tougher sell than an overfit model. If the great unwashed (but white collar) masses like your 'model', you are probably going to fail if your goal is to predict well. A good model should cause unsophisticated people (i.e., most people) to think your model is insufficiently complex, because, intuitively, it is missing components X, Y and Z we see in actual data. But adding X, Y and Z merely increases the mean-squared error. Modeling 'feature creep' comes from giving people what they want, rather than what they need.

http://falkenblog.blogspot.de/2008/06/good-forecasts-will-strike-most-people.html |

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

zelig

Kultürlich

Anmeldungsdatum: 31.03.2004

Beiträge: 25405

|

(#1914184) Verfasst am: 06.04.2014, 02:07 Titel: (#1914184) Verfasst am: 06.04.2014, 02:07 Titel: |

|

|

| Zitat: | We need philosophers to tackle the big cosmic puzzles

MODERN cosmology has been spectacularly successful at explaining why the universe is as it is – a geometrically flat expanding space pockmarked with stars and galaxies. But this very success means that attempts to understand its origin increasingly stray into issues beyond physics and into the realm of philosophy, for which cosmologists rarely have any formal training. Likewise, when philosophers, untrained in astrophysical subtleties, pronounce on cosmology, the cosmologists are unimpressed. Clearly both groups have much to learn from each other. |

http://www.newscientist.com/article/mg22129590.400-we-need-philosophers-to-tackle-the-big-cosmic-puzzles.html

| Zitat: | When science and philosophy collide in a 'fine-tuned' universe

When renowned scientists now talk seriously about millions of multiverses, the old question "are we alone?" gets a whole new meaning.

Our ever-expanding universe is incomprehensibly large – and its rate of growth is apparently accelerating – but if so it's actually in a very delicate balance.

It's then incredible that the universe exists at all. Let us explain.

[...]

Modern science needs philosophy

With this backdrop, a growing number of scientists are calling for head-to-head interactions with philosophers. In a recent New Scientist article, cosmologist Joseph Silk reviews these and other issues now faced by the field, and then notes that such problems, probing the meaning of our very existence, are closely akin to those that have been debated by philosophers through the ages.

Thus perhaps a new dialogue between science and philosophy can bring some badly needed insights into physics and other leading-edge fields such as neurobiology. (Indeed, there is a burgeoning sub discipline of neurophilosophy.)

As Silk explains, "Drawing the line between philosophy and physics has never been easy. Perhaps it is time to stop trying. The interface is ripe for exploration."

|

http://phys.org/news/2014-04-science-philosophy-collide-fine-tuned-universe.html

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1914561) Verfasst am: 07.04.2014, 23:56 Titel: (#1914561) Verfasst am: 07.04.2014, 23:56 Titel: |

|

|

Aus zeligs Link:

| Zitat: | When science and philosophy collide in a 'fine-tuned' universe

In a similar vein, string theory, the current best candidate for a "theory of everything," predicts an enormous ensemble, numbering 10 to the power 500 by one accounting, of parallel universes. Thus in such a large or even infinite ensemble, we should not be surprised to find ourselves in an exceedingly fine-tuned universe.

[...]

But others see no alternative to some form of the multiverse and the Anthropic Principle. Physicist Max Tegmark, in his recent book Our Mathematical Universe, argues that not only is the multiverse real, but in fact that the multiverse is mathematics—all mathematical laws and structures actually exist, and are the ultimate stuff of the universe.

http://phys.org/news/2014-04-science-philosophy-collide-fine-tuned-universe.html |

Meine Sicht auf diese Themen hat sich jüngster Zeit etwas gewandelt. Inzwischen denke ich, solche Thesen haben keinen fassbaren Gehalt, auch wenn sie metaphysisch faszinierend sind.

String-Theorie ist nicht die "Theory of Everything", sie ist eine "Theory of Anything". Sie kann alles und jedes erklären, jede mögliche Welt. Was nutzt eine These, die sagt: es könnte so sein, aber auch anders?

Tegmarks mathematisches Universum - natürlich hat das Universum eine regelmäßige = mathematische Struktur. Das ist meiner Ansicht nach ein no brainer. Wie oft wurde schon gesagt, Gott sei ein Mathematiker? Tegmarck liefert nur die säkulare Variante dieses Gedankens. Daraus lernen wir aber nichts über die konkret vorliegende Struktur und wie es dazu kam.

Hier die übliche Hierarchie der Multiversen:

| Zitat: | Typ I - Räumliche Unendlicheit

Typ II - Unterschiedliche Naturkonstanten in unterschiedlichen Räumen

Typ III - Vielweltenthese der Quantenmechanik

Typ IV - Tegmarks mathematische Universum, in dem jede endlich berechenbare Welt existiert |

Ich denke, ein Fall fehlt in dieser Aufzählung:

Typ V - Simula-Multiversum: sollten wir irgendwann anfangen, eine Welt zu simulieren, so liegt der Gedanke nahe, auch unsere Welt könne eine Simulation sein. Die Gesetze unserer Welt wären willkürliche Setzungen der Programmierer. Vergesst String-Theorie. Es geht darum, die Intentionen der Programmierer herauszufinden.

Eine gute Heuristik, um eine These zu testen, ist der Versuch, sie ins Absurde zu treiben. Auf smileys habe ich verzichtet, bitte gedanklich ergänzen.

Typ VI - das hartcodierte mathematische Universum. Ich hab Tegmarcks Buch nicht gelesen, erwähnt er, daß man ein mathematisches Universum auch ohne mathematische Gleichungen beschreiben kann - sofern das Universum simuliert oder die Raumzeit gequantelt ist? Dann reicht ein langer String, in dem alles codiert ist, was im Universum geschieht. Der String kann jederzeit als Zahl gelesen werden. Die berühmte Lösung von Adams, 42, ist aber bestimmt falsch.

Typ VIb - das Multiversum der Eulerschen Zahl, meinetwegen auch pi-Multiversum. Da e und pi Normale Zahlen sind, findet sich irgendwo in den Stellen auch obiger String, der unser Universum codiert. Die Forschung sollte sich deshalb darauf konzentrieren, welche Normale Zahl unser Universum am Besten beschreibt.

Typ VII - das Universum des mathematischen Schindludertreibens aka, das Multiversum der undifferenzierbaren Funktionen. Tegmarks Version des mathematischen Universums scheint eine Sammlung stetig differenzierbarer Funktionen zu sein. Irgendwo in seinem Lösungsraum ist die Antwort auf unsere heutigen Probleme mit Singularitäten versteckt. Wo genau, das kann er nicht sagen. Aber das nur nebenbei. Worauf ich hinaus will: ich kann auch mit Tegmarcks mathematischem Universum Schindluder treiben. Aus der Menge aller seiner mathematischen Beschreibungen wähle ich jene aus, die die selben "Entitäten" enthalten. Diese nummeriere ich: 1, 2, 3, 4... Dann bau ich mir einen Schalter, zum Beispiel indem ich Zeit t modulo der Anzahl der Beschreibungen nehme. Was als Rest herauskommt, schaltet zwischen den 1 .. n Beschreibung um und bestimmt, was für diesen Zeitabschnitt gilt. Mathematisch scheint mir das machbar zu sein. Jedem Physiker, jedem Empiriker, dürften bei diesem Schindluder die Haare zu Berge stehen.

Fazit:

Die üblichen Multiversumstheorien können nur regelmäßige Universen erklären. Meine Varianten zum nicht stetig differenzbaren Multiversum haben noch viel mehr Freiheitsgrade. Sie sind deshalb die mächtigere Theorie.

Ich hoffe ich habe das Prinzip jetzt genug malträtiert, um meine Kritik anschaulich zu machen.

Ein Philosoph nach meinem Geschmack würde sagen: "Grämt euch nicht. Zu jeder Zeit gibt es Dinge, die mysteriös erscheinen. Trennt sauber zwischen Theorie, These und Metaphysik, bleibt auf dem Boden der Tatsachen - dann fällt auch ein Hans-Guck-in-die-Luft nicht auf die Schnauze."

PS:

Der Artikel versäumt auf die Diskussion zwischen Susskind und Smolin hinzuweisen. Smolin vs. Susskind: The Anthropic Principle

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1914570) Verfasst am: 08.04.2014, 00:58 Titel: (#1914570) Verfasst am: 08.04.2014, 00:58 Titel: |

|

|

via andrewgelman.com

http://andrewgelman.com/2014/04/07/literature-like-statistical-reasoning-kosara-stories-gelman-basboll-stories/

Gelman, A /Basbøll, T. (2014): When do stories work? Evidence and illustration in the social sciences. Wird in Sociological Methods and Research erscheinen frei verfügbar unter: http://www.stat.columbia.edu/~gelman/research/published/Storytelling_as_Ideology_13.pdf

| Zitat: | Storytelling has long been recognized as central to human cognition

and communication. Here we explore a more active role of stories in social

science research, not merely to illustrate concepts but also to develop new

ideas and evaluate hypotheses, for example in deciding that a research method

is effective. We see stories as central to engagement with the development

and evaluation of theories, and we argue that for a story to be useful in this

way, it should be anomalous (representing aspects of life that are not well

explained by existing models) and immutable (with details that are wellenough

established that they have the potential to indicate problems with a

new model). We develop these ideas through considering two well-known

examples from the work of Karl Weick and Robert Axelrod, and we discuss

why transparent sourcing (in the case of Axelrod) makes a story a more

effective research tool, whereas improper sourcing (in the case of Weick)

interferes with the key useful roles of stories in the scientific process. |

Sehr interessanter Text, welche Rolle *gute* Stories - nicht nur - in der Sozialforschung spielen und was das mit Statistik zu tun hat.

Inebsondere!

| S. 13 hat folgendes geschrieben: | One might imagine a statistician criticizing storytellers for selection bias, for choosing the amusing, unexpected, and atypical rather than the run-of-the-mill boring reality

that should form the basis for most of our social science. But then how can we also

say the opposite, that stories benefit from being anomalous? We reconcile this

apparent contradiction by placing stories in a different class of evidence from

anecdotal data as usually conceived. The purpose of a story is not to pile on evidence

in support of one theory or another but rather to shine a spotlight on an anomaly—a

problem with an existing model—and to stand as an immutable object that conveys

the complexity of reality. |

_________________

"A basic literacy in statistics will one day be as necessary for efficient citizenship as the ability to read and write." (angeblich H. G. Wells)

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1915062) Verfasst am: 09.04.2014, 22:04 Titel: (#1915062) Verfasst am: 09.04.2014, 22:04 Titel: |

|

|

Ich mag Geschichten. Das Schöne an Geschichten, Gedankenexperimenten, Beispielen ist, daß sie konkret und darum wenig mißverstehbar sind. Bei abstrakt gesagtem weiß ich nie, ob sich mein Verständnis des Gesagten mit dem Gemeinten deckt.

| Kival hat folgendes geschrieben: | | Sehr interessanter Text, welche Rolle *gute* Stories - nicht nur - in der Sozialforschung spielen und was das mit Statistik zu tun hat. |

Der Ansatz erinnert mich ein bisschen an John Allen Paulos Es war 1mal / Once upon a number.

Die Geschichte von der Karte in ihren drei Varianten fand ich köstlich.

Darüber will ich mehr wissen:

| Zitat: | | Second, we discuss political scientist Robert Axelrod’s highly influential gametheoretic model of cooperation in the trenches during the First World War. As Gowa (1986) showed, Axelrod's analysis can be disputed using details that can be found both in Axelrod's careful retelling of the story and his scrupulously referenced sources. |

Axelrods Arbeit zu Tit-for-Tat war prägend für meine Ansichten. Aus Spaß an der Freud' hab' ich vor einigen Jahren seinen Tit-for-Tat-Evolver nachprogrammiert. Und über das, was er von den Schützengräben im ersten Weltkrieg schreibt, davon wollte ich hier im Forum schon seit langem berichten. Aber, ach, die Zeit...

Ich muß mir mal durch den Kopf gehen lassen, was im Artikel weiter unten kurz angerissen wird.

Das siehe ich anders:

| Zitat: | | organizational psychologist James March [...] even goes on to argue that there is little difference between fiction, like Anton Chekhov’s short stories, and social research, like Karl Weick’s analyses of crises |

Diese Bemerkung ist etwas zu kurz, um wissen zu können was gemeint ist. Aber bei Tschechow denke ich an seine Forderung: Man kann kein Gewehr auf die Bühne stellen, wenn niemand die Absicht hat, einen Schuss daraus abzugeben. Und: Wenn im ersten Akt ein Gewehr an der Wand hängt, dann wird es im letzten Akt abgefeuert. In der Statistik sollte das anders sein - wenn man sauber arbeitet und auch von den verworfenen Hypothesen berichtet.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

smallie

resistent!?

Anmeldungsdatum: 02.04.2010

Beiträge: 3726

|

(#1919381) Verfasst am: 30.04.2014, 23:45 Titel: (#1919381) Verfasst am: 30.04.2014, 23:45 Titel: |

|

|

Das ist wunderschön. Aber bisher nur eine Hypothese.

Biophonie und die These der akustischen Nischen

Unterschiedliche Tiere machen unterschiedliche Geräusche.

Ein Amateur behauptet, die Geräusche, die die unterschiedlichen Art machen, fänden in unterschiedlichen Frequenzbereichen statt. Salopp gesagt, sendet jede Art auf ihrer eigenen Frequenz. Zumindest in stabilen Ökosystemen sei das so.

Das hat sich herumgesprochen. Inzwischen laufen Feldversuche, um zu sehen, ob sich anhand von Aufnahmen der Bioklangsphäre etwas über den Zustand eines Ökosystems sagen läßt.

Übrigens, der Artikel ist keine wissenschaftliche Veröffentlichung, sondern Journalismus.

| Zitat: | Decoding Nature's Soundtrack

[...]

In his home studio, [...] Krause plays me some of his favorites: a Florida swamp, old-growth forest in Zimbabwe, intertidal mangroves in Costa Rica, and a Sierra Nevada mountain meadow. As the sounds pour from speakers mounted above his computer, spectrograms scroll across the screen, depicting visually the timing and frequency of every individual sound. They look like musical scores.

In each spectrogram, Krause points something out: No matter how sonically dense they become, sounds don’t tend to overlap. Each animal occupies a unique frequency bandwidth, fitting into available auditory space like pieces in an exquisitely precise puzzle. It’s a simple but striking phenomenon, and Krause was the first to notice it. He named it biophony, the sound of living organisms, and to him it wasn’t merely aesthetic. It signified a coevolution of species across deep biological time and in a particular place. As life becomes richer, the symphony’s players find a sonic niche to play without interference.

[...]

It took a while for Krause’s observation, initially made informally in the early 1980s, to reach sympathetic scientific ears. Krause was not, after all, a member of the scientific community. [...]

But the idea of biophony struck a chord with Stuart Gage, an ecologist at Michigan State University interested in using sounds to take the pulse of ecosystems and monitor their ecological health. He and Krause recorded Sequoia National Park, using an early gauge of acoustic complexity, measuring patterns of species diversity across different habitats and seasons. It was a proof-of-principle test, and in recent years, with the advent of inexpensive recorders and big hard drives that make it possible to record large areas over long periods of time, the field—now dubbed “soundscape ecology”—has flourished.

Researchers are now recording dozens of landscapes across the world and computationally translating thousands of hours of recordings into numerical indexes of ecological conditions, and ultimately the human impacts on them. These are not ready for practical application. The biophony, formally known as the “niche hypothesis,” is still a hypothesis. It’s not yet possible to hear whether an ecosystem is healthy.

http://nautil.us/issue/12/feedback/decoding-natures-soundtrack |

Bin gespannt, ob daraus was wird.

Milde Kritik ist angebracht wegen der undifferenzierten Verwendung von "healthy". Ein Ökosystem könnte gesund und trotzdem im Umbruch sein. Ungesund wäre eine Verarmung. Und auch das läßt sich hinterfragen. Ohne mehrfache Verarmung nach evolutionären Katastrophen gäbe es uns heute vermutlich nicht.

Ob man mit dieser Methode mehr herausbringen kann, als mit einer herkömmlichen Zählung der Artenvielfalt in einem Habitat? Vielleicht geht es mit der akustischen Variante einfacher, kleinräumiger und billiger.

_________________

"There are two hard things in computer science: cache invalidation, naming things, and off-by-one errors."

|

|

| Nach oben |

|

|

Kival

Profeminist Ghost

Anmeldungsdatum: 14.11.2006

Beiträge: 24071

|

(#1920127) Verfasst am: 04.05.2014, 19:11 Titel: (#1920127) Verfasst am: 04.05.2014, 19:11 Titel: |

|

|

| Kival hat folgendes geschrieben: | | Im Kontext der Debatte um die Schwierigkeiten, wissenschaftliche Studien zu reproduzieren, argumentiert Valen Johnson, dass das Problem die zu anspruchslosen Signifikanzniveaus sind. Er benutzt eine neue Variante Bayesianischer Tests, die eine direkte Vergleichbarkeit mit den üblichen frequentistischen Tests erlauben soll und zeigt, dass - ausgehend von 50 % korrekten Nullhypothesen - Alternativhypothesen bei dem Standard p-value von 0,05 zu zwischen 18 und 23 % fälschlicherweise als richtig angesehen werden. Dies entspricht wohl auch ungefähr der Größenordnung zu der Ergebnisse nicht repliziert werden können. Selbst ein P-Wert von 0,01 wäre noch zu schwach und er fordert einen neuen Standard von 0,005 (Johnson 2013, 4). |

Im Laufe der Zeit gab es einige Kritiken gegen Johnsons Ansatz. Andrew Gelman hat eine Zusammenfassung seiner Kritik zusammen mit Links zu anderen Kritiken, die in PNAS veröffentlicht wurden, auf seinem Blog veröffentlicht: